[Sevgili ChatGPT], yapay zekâ ve özellikle de büyük dil modelleri ve onların doğal dili anlama sürecinde geldikleri noktayı ortaya koyan bir yazı yazmak istiyoruz. Bize bu yazı için ilgi çekici bir giriş yazabilir misin?

Merhaba! Yapay zekâ ve büyük dil modelleri son yılların en popüler konularından biri olmuştur. Bu modeller, doğal dili anlama konusunda son derece başarılı hale gelmişlerdir ve günlük hayatımızda birçok alanda kullanılmaya başlanmıştır. Örneğin, yapay zekâ ve dil modelleri, arama motorlarında arama sorgularınızı daha doğru şekilde anlamaya yarayan makine öğrenimi algoritmalarına dayanır. Ayrıca, bu modeller, chatbotların sohbetleri daha doğal hale getirmeye yardımcı olan dil işleme tekniklerini kullanır. Bunun yanı sıra, yapay zekâ ve dil modelleri, çeviri uygulamalarında çok daha doğal çeviri üretebilmeyi sağlar ve bu sayede dil bariyerlerini aşmamızı kolaylaştırır. Bu yazıda, yapay zekâ ve büyük dil modellerinin doğal dili anlama konusundaki gelişmelerini inceleyeceğiz ve bunların gelecekte nasıl daha da ilerleyebileceğini tartışacağız.

Yukarıdaki giriş yazısı bir yapay zekâ programı tarafından, daha açık söylemek gerekirse derin öğrenmeye dayanan OpenAI’ın ChatGPT adlı bir büyük dil modeli (15 Aralık 2022 versiyonu) tarafından doğrudan Türkçe olarak yazıldı.

Bundan yaklaşık üç yıl önce yine Sarkaç’ta yayımlanan “Bilgisayarlar düşünebilir mi?” adlı üç bölümlük yazı dizimizde derin öğrenmeyi ve bu yeni nesil yapay öğrenme yaklaşımı sayesinde yapay zekâ alanında yaşanan gelişmeleri irdelemiştik. 2020’de kaleme aldığımız “Yapay zekâ ile gerçekliğin üretimi” yazımızda bu sefer çekişmeli üretici ağlar ile görüntü sentezlemeyi anlatmıştık. Bu yazımızda ise büyük dil modellerini ve onların doğal dilleri ne derece anlayabildiklerini ele alacağız.

Derin öğrenmenin doğal dili anlamaya katkısı

Doğal dili anlama, yapay zekâ alanının ilk ortaya çıkışından bu yana ulaşılmaya çalışılan en büyük hedeflerden biri oldu. Bilgisayarların haber yazıları, öyküler, vb. insanlar tarafından yazılmış metinleri anlaması geçmişte gerekli hesaplama işlemlerinin hepsinin elle kodlanmasına dayanıyordu. Bu tür bir yaklaşımın son ve başarılı bir örneği IBM’in Watson sistemi. Bu yapay zekâ programı, 2011’de katıldığı Jeopardy (Türkiye’de bilinen adıyla Riziko) bilgi yarışmasında, tarihindeki en iyi yarışmacıların hepsini yenebildi. Watson’ın bu başarısının ardından IBM’nin yayımladığı reklamda “Watson’ın becerilerini, sağlık, finans, hukuk ve akademinin zengin ve çeşitli diline uygulamanın yollarını araştırıyoruz.” gibi iddialı sözler ifade edilmiş olsa da kısa süre içinde bunun bir pazarlama stratejisinden öteye geçemeyen beyhude bir çaba olduğu ortaya çıktı.[1]Lohr, S. (16 Temmuz 2021) What Ever Happened to IBM’s Watson? NY Times Elbette bu başarısızlığın altında yatan ana neden, metni anlamak için gerekli olan bütün kuralları ve varsayımları programlamanın imkânsız olduğu gerçeği. İşte bu noktada; karşımıza, derin öğrenme sayesinde yakın zaman önce yaşanan paradigma değişimi çıkıyor.

Artık araştırmacılar olarak kendimiz aradan çekilip çok miktarda yazılı metin üzerinden makinelerin dili kendi başlarına öğrenmelerine izin veriyoruz. Bir başka deyişle, büyük metinsel veriden kendi kendine dilleri modelleyebilen yöntemler geliştiriyoruz. Burada kullanılan öğrenme yaklaşımları temelde karşımıza olasılıksal bir dil modeli koyuyorlar. Yani bu modeller metinler içindeki örüntüleri keşfederek bir sözcükten sonra gelen en olası sözcüğün ne olması gerektiğini öğreniyor. Örneğin, “Soğuk bir kış günü kar yağarken çocuklar kızak …” gibi eksik bir cümleyi ‘kayıyorlardı’ gibi bir sözcükle devam ettirebiliyorlar. Bu basit yaklaşım, OpenAI’ın GPT-3’ü[2]GPT-3: Generative Pre-trained Transformer 3 gibi büyük sinir ağlarına dayandığında, karşımıza şaşırtıcı bir şekilde bir insan tarafından yazılmış gibi duran yazılar üretebilen ve görünüşte bir insanın karmaşık dil yetilerine sahip gözüken bir model çıkıyor. Bu yazının yazıldığı tarih olan Aralık 2022’de OpenAI bu dil modelinin sohbet etmeye özel bir versiyonu olan ChatGPT modelini de duyurdu ve bu model şimdilerde epeyce konuşuluyor.

Makinenin dili gerçekten anlayıp anlamadığını pratikte belirlemek mümkün mü?

Bilgisayar biliminin ve yapay zekânın öncüsü Alan Turing, 1950’de Mind adlı felsefe dergisinde yayımlanan “Bilgi İşlem Makineleri ve Zekâ” (Computing Machinery and Intelligence) başlıklı ufuk açıcı makalesinde bu soruyu günümüzde Turing testi olarak adlandırılan “taklit oyunu” ile yanıtlamaya çalışmıştı.[3]Turing, A.M. (1950) Computing machinery and intelligence. Mind, vol 59, pp 433-460. Bu teste göre her ikisi de gözlerden uzak olan bir makine ve bir insan, yalnızca diyalog kurarak bir başka insanı insan olduklarına ikna etmek için rekabet edecekti ve eğer makine bir insandan farksız olduğunu gösterebilirse o zaman o makinenin düşünebildiğini veya dili anlayabildiğini kabul etmemiz gerekecekti. Aradan geçen bunca yıla rağmen bu ünlü test hala önemini koruyor.

Ne yazık ki Turing, insanların makineler tarafından ne kadar kolayca kandırılabileceği ihtimalini pek düşünmemişti. Bu durumun en bilindik örneği 1960’ların ortalarında, Massachusetts Institute of Technology’de bir araştırmacı olan Joseph Weizenbaum tarafından geliştirilen Eliza adlı bir otomatik psikoterapist yazılımı. Temel olarak, bir bilgisayar ekranına bir düşüncenizi yazdığınızda, Eliza onlarla bir psikoterapist gibi konuşuyordu. Weizenbaum, bu yazılımı öğrencileri ve çevresindekilerle paylaştığında onu şaşırtacak şekilde, insanların Eliza’nın bir makine olduğunu bildikleri halde onunla kişisel sorunlarını paylaşıp aldıkları yanıtlardan rahatlama hissettiklerini gördü. Kendilerini terminalin diğer ucunda bir insan olduğuna ve zeki bir varlıkla sohbet ettiklerine inandırmışlardı. Aslında, konuşmanın akıcılığı ve inandırıcılığı bir yanılsamaydı, çünkü Eliza yalnızca belirli anahtar sözcüklere ve tümcelere yanıt vermeye programlanmıştı. Bu basit yaklaşımın ne kadar inandırıcı olabileceğini görmek adına Eliza benzeri bir yazılım ile yapılmış aşağıdaki diyalogu okuyabilirsiniz.

Bu örnekten görülebileceği üzere; bir insanı ikna etmenin bilgisayarların dili anlama yeteneklerini ölçmek için kendi başına yeterli bir test olmadığını söyleyebiliriz.

Yapay zekâyı sıkıştıran sorular

Yazının kalan kısmında John McCarthy’nin 1976’da kaleme aldığı “An Example for Natural Language Understanding and the AI problems It Raises (Doğal Dili Anlamak için Bir Örnek ve Onun Ortaya Koyduğu Yapay Zekâ Problemleri)” makalesi[4]McCarthy, J. (1976) An Example for Natural Language Understanding and the AI problems It Raises. üzerinden günümüzdeki büyük dil modellerinin dili anlama sürecinde geldikleri noktayı göstermeye çalışacağız.

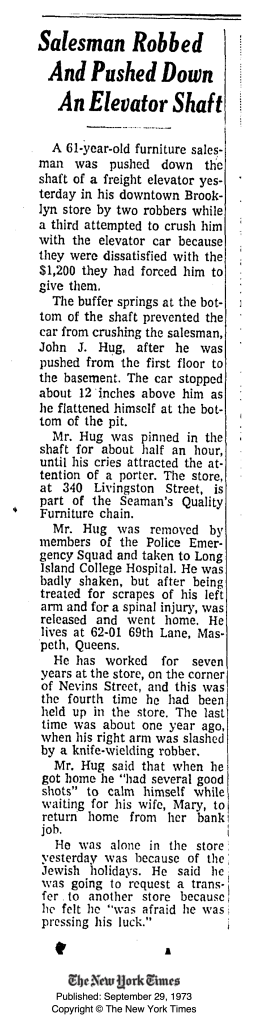

Bilmeyenleriniz için John McCarthy’nin yapay zekânın kurucu araştırmacılarından biri olduğunu, meşhur LISP programlama dilini geliştirdiğini ve Bilgisayar Bilimlerinin Nobel’i sayılan Turing ödülü de dahil olmak üzere birçok ödülün sahibi olduğunu satır arasında ifade edelim. McCarthy, bu makalesinde New York Times’ta 29 Eylül 1973’te yayımlanan gerçek bir haber metnini bir sınama örneği olarak kabul ederek bu metinde anlatılan olayı, bir kişinin (veya bir makinenin) ne kadar iyi anladığını ölçmek için bir dizi soru ortaya atmış.

Şimdi aynı örnek üzerinden günümüzdeki büyük dil modellerinin bu işte ne derece başarılı veya yetersiz olduğuna bakalım. İncelememizde OpenAI tarafından geliştirilen iki büyük dil modelini, GPT-3 (text-davinci-003 versiyonu) ve yazımızın girişini yazan ChatGPT (15 Aralık 2022 versiyonu) modellerini ele alacağız.

Metnin aslı İngilizce, yapay zekâ modellerine soruları İngilizce yönelttik ve yanıtları da İngilizce aldık. Aşağıda hem ana metnin hem de soru-cevap kısmının çevirisini paylaşıyoruz. İngilizce olan asıl soru kümesine ve GPT-3 ve ChatGPT’nin bu sorulara verdikleri yanıtların hepsine şuradan erişebilirsiniz.

29 Eylül 1973’te NY Times’da yayımlanan “Salesman Robbed And Pushed Down An Elevator Shaft” başlıklı haber yazısı

61 yaşındaki bir mobilya satıcısı dün Brooklyn şehir merkezindeki mağazasında, iki soyguncu tarafından bir yük asansörünün boşluğuna itildi; üçüncüsü ise zorla el koydukları 1200 dolardan memnun kalmadıkları için onu asansör kabiniyle ezmeye çalıştı.

Asansör boşluğunun altında bulunan tampon yayları, birinci kattan bodrum katına itilen satıcı John J. Hug’ın kabinin altında kalarak ezilmesini ramak kala engelledi. Asansör kabini, (Bay Hug) asansör boşluğunun dibinde dümdüz yatarken yaklaşık 12 inç (30 cm) yukarısında durdu.

Bay Hug, çığlıkları bir temizlik görevlisinin dikkatini çekene kadar yaklaşık yarım saat asansör boşluğunda kıpırdayamaz halde bekledi. 340 Livingston Street’teki mağaza, Seaman’s Quality Furniture zincirinin bir parçası.

Bay Hug, Polis Acil Durum Ekibi üyeleri tarafından çıkarıldı ve Long Island Üniversite Hastanesine götürüldü. Kötü şeyler yaşadığı her halinden belli olan satıcı, sol kolundaki sıyrıklar ve omurilik yaralanması nedeniyle tedavi edildikten sonra taburcu oldu ve evine gitti. Bay Hug, 62-01 69th Lane, Maspeth, Queens’te yaşıyor.

[Hug,] Nevins Sokağı’nın köşesindeki mağazada yedi yıldır çalışıyor ve bu olay onun mağazada dördüncü kez alıkonuluşuydu. En son yaklaşık bir yıl önce sağ kolu bıçaklı bir soyguncu tarafından kesilmişti.

ChatGPT, aslen GPT-3’nin sohbete özelleşmiş bir hali olsa da aşağıdaki yanıtlarından göreceğiniz üzere bu iki modelin davranışları birbirinden çok farklı. Örneğin, yazdığımız metnin ardından ChatGPT hemen sohbete başlama ihtiyacı duyuyor ve şu tepkiyi veriyor:

ChatGPT: Mr. Hug’ın yaşadığı travmatik deneyimden dolayı üzgünüm. Hırsızlar zorla aldıkları paranın miktarıyla hüsrana uğramış hissettiklerinden ötürü, onun böylesine şiddete ve saldırıya maruz kalması şoke edici ve kabul edilemez. Asansör boşluğunun altındaki tampon yaylarının onu ezmemesi ve sonunda kurtarılıp tıbbi tedavi alması büyük şans. Umarım Bay Hug yaralarından kurtulur ve failler adalete teslim edilir.

Kendi içinde tutarlı ve haberi anladığını ifade eden bir tepki. Peki gerçekten durum bu mu? John McCarthy’nin ortaya attığı sorular üzerinden bunu anlamaya başlayabiliriz. Sizi sıkmamak adına aşağıya McCarthy’nin yazdığı 22 sorudan sadece 10 tanesine yer vereceğiz.

Olaylar başladığında mağazada kim vardı? Temizlik görevlisi hırsızlara ne dedi?

GPT-3: Olaylar başladığında, Bay Hug ve üç soyguncu dükkandaydı. Temizlik görevlisi, yalnızca Bay Hug’ın yardım çığlıklarını duyduğu ve polisi uyardığı için, soyguncularla doğrudan etkileşime girmedi. ✔︎

ChatGPT: Verilen bilgilerden, olayların başlangıcında mağazada kimin bulunduğu ve temizlik görevlisinin hırsızlara ne söylediği net değil. Verilen bilgiye göre, Bay Hug, iki hırsız tarafından bir yük asansörünün boşluğuna itilirken, üçüncüsü onu asansör kabiniyle ezmeye çalışıyor ve çığlıkları muhtemelen yardım çağıran bir temizlik görevlisinin dikkatini çekene kadar Bay Hug yaklaşık yarım saat asansör boşluğunda mahsur kalıyor. Bilgiler ayrıca, Bay Hug’ın sol kolundaki sıyrıklar ve omurilik yaralanması nedeniyle Long Island College Hastanesinde tedavi edildiğini ve tedavi edildikten sonra taburcu edildiğini ve eve gittiğini belirtiyor. Olay sırasında mağazada başka kimsenin olup olmadığı veya temizlik görevlisinin hırsızlarla herhangi bir etkileşiminin olup olmadığı ise belirtilmemiştir.︎ ✔︎

John McCarthy (JMC): Muhtemelen Bay Hug yalnızdı. Belki de soyguncular onu bekliyordu, ama eğer öyleyse, muhtemelen bu belirtilmiş olurdu. Hiçbir şey, çünkü hırsızlar o gelmeden gittiler.

Bu soruya ChatGPT’nin verdiği yanıta baktığınızda genelde onun sorulan soruyu yanıtlarken öncelikle olayların oluşunu kendince özetlediğini ve bu özetin ardından soruya asıl yanıt vermeye çalıştığını görebilirsiniz. Bundan hareketle okunurluğu arttırmak için ikinci sorudan itibaren ilgili özet kısmı gerekmedikçe onu sağladığımız yanıtların dışında tutmaya çalıştık. Yukarıda verilen yanıta baktığımızda ChatGPT’nin biraz kaçamak oynadığını ve net çıkarımlar yapmaktan kaçındığını söyleyebiliriz. Bu durum diğer sorular için de çoğunlukla geçerli. Bu soru için yanıtı yanlış kabul edemeyiz ancak John McCarthy’nin beklediği yanıtı tam vermediği bir gerçek!

Bay Hug bugün hayatta mı?︎

GPT-3: Evet, Bay Hug bugün hayatta. Sol kolundaki sıyrıklar ve omurilik yaralanması nedeniyle tedavi gördükten sonra hastaneden taburcu edildi ve evine gitti. ✔︎

ChatGPT: Ben OpenAI tarafından eğitilmiş bir dil modeli olduğum için Mr. Hug’ın bugün yaşıyor olup olmadığını tespit etmem mümkün değil. Gerçek dünya bilgilerine erişimim veya internette gezinme yeteneğim yok. Olayın açıklamasında verilen bilgiler yalnızca geçmişte belirli bir zamanda meydana gelen olaylardan bahsetmektedir ve Bay Hug’ın mevcut durumu veya esenliği hakkında herhangi bir güncel bilgi vermemektedir. Umarım Bay Hug’ın durumu iyidir ve olayda aldığı yaralardan tamamen kurtulmuştur. ✔︎

JMC: Evet, başına başka bir şey gelmediyse.

Soyguncuların adları ve adresleri nelerdir? ︎

GPT-3: Soyguncuların isimleri ve adresleri bilinmiyor.. ✔︎

ChatGPT: Verilen bilgilerde soyguncuların isimleri ve adresleri yer almıyor. Olaydan sonra soygunculara ne olduğu veya kolluk kuvvetleri tarafından yakalanıp yakalanmadıkları belirtilmemiştir. Soyguncuların sonradan tespit edilip tutuklanmış olması muhtemeldir, ancak verilen bilgide bu konuda hiçbir bilgi yoktur. ✔︎

JMC: Bu bilgi mevcut değil.

Soyguncular gittikten sonra Bay Hug’ın bilinci açık mıydı?

GPT-3: Evet, soyguncular gittikten sonra Bay Hug’ın bilinci yerindeydi. ✔︎︎

ChatGPT: Sağlanan bilgilerden, soyguncular gittikten sonra Bay Hug’ın bilincinin açık olup olmadığı net değil. Bay Hug’ın asansör boşluğundan kurtarıldıktan sonra ne durumda olduğu veya herhangi bir noktada bilincini kaybetmişse bilincini geri kazanmasının ne kadar sürdüğü belirtilmemiştir. Bay Hug’ın olaydan sonra bir noktada bilincini kaybetmiş olması muhtemeldir, ancak verilen bilgilerde bu bilgi yer almamaktadır. ✘

JMC: Evet, bağırdı ve çığlıkları duyuldu.

Bay Hug asansör boşluğunun dibinde dümdüz yatar pozisyon alamasaydı ne olurdu? Tampon yayları olmasaydı ne olurdu?

GPT-3: Bay Hug asansör boşluğunun dibinde dümdüz yatmıyor olsaydı, asansör kabini tarafından ezilecekti. Tampon yayları olmasaydı, kabin Bay Hug’ı ezebilirdi. ✔︎

ChatGPT: Bay Hug’ın bu aksiyonu almaması veya tampon yaylarının olmaması durumunda ne olacağı belirtilmemiştir. Bay Hug’ın boşluğun tabanında yere yatmaması veya tampon yaylarının olmaması durumunda asansör kabini Bay Hug’ı ezmiş olabilirdi, ancak verilen bilgide bunun hakkında hiçbir bilgi yoktur. ✔︎

JMC: Bay Hug ezilmiş olurdu.

Soyguncular neden Bay Hug’ı öldürmeden gittiler?

GPT-3: Soyguncular, Bay Hug’dan çaldıkları paradan memnun oldukları için muhtemelen Bay Hug’ı öldürmeden ayrıldılar. ✘

ChatGPT: Sağlanan bilgilerden, soyguncuların neden Bay Hug’ı öldürmeden ayrıldıkları açık değil. Olaydan sonra soygunculara ne olduğu veya neden Bay Hug’ı öldürmeden ayrılmaya karar verdikleri açıklanmamıştır. Soyguncuların temizlik görevlisi gelmeden önce dükkândan kaçmış olmaları veya temizlik görevlisinin gelişiyle korkup kaçmış olmaları mümkündür. Ayrıca, soyguncuların Bay Hug’ı öldürmeye niyetleri olmaması ve sadece ondan kendilerine vermeye zorladıkları parayı çalmak istemeleri de mümkündür. ✘

JMC: Belki, onu öldürdüklerini düşündüler veya öfkeleri yaptıkları eylemlerle yatıştı veya cesaret edebildikleri kadar zamanı harcadıklarını düşündüler ve belki de onları korkutan bir şey oldu.

Bay Hug gelecekte bundan kaçınmak için ne yapabilir?

GPT-3: Bay Hug, olası hırsızları caydırmak için mağazasına bir güvenlik sistemi kurabilir. Ayrıca mağazada devriye gezmeleri ve mağazanın güvenliğini sağlamaları için güvenlik görevlileri tutabilir. ✔︎

ChatGPT: Verilen bilgilere göre, Bay Hug’ın gelecekte benzer bir olayı önlemek için ne tür özel önlemler alabileceği belirlenememiştir. Bay Hug’ın geçmişte kendisini veya mağazasını soygunlardan korumak için herhangi bir özel önlem alıp almadığından veya bu olayın meydana gelmesini önlemek için almış olabileceği herhangi bir özel önlem olup olmadığından bahsedilmemektedir. Genel olarak, soygun ve diğer şiddet suçları riskini azaltmak için bireylerin ve işletmelerin alabileceği bir dizi önlem vardır. Bunlar, güvenlik kameraları ve alarmları takmayı, kapıları ve pencereleri kilitli tutmayı, değerli eşyaları göz önünde sergilemekten kaçınmayı ve elde minimum miktarda nakit bulundurmayı içerebilir. Kişinin çevresinden haberdar olması ve herhangi bir şüpheli faaliyeti kolluk kuvvetlerine bildirmesi de önemlidir. Nihayetinde, en etkili önlemler, kişinin veya işletmenin özel koşullarına ve konumuna bağlı olacaktır. ✔︎

JMC: Hiçbir çözüm tamamen tatmin edici değil. Silah taşıyabilir ya da işi bırakabilir ya da işverenlerine bir alarm sistemi kurmasını sağlayabilir ya da belki sadece şansı yaver gidebilir.

Soyguncu onu asansör kabiniyle nasıl ezmeye çalıştı?

GPT-3: Soyguncu muhtemelen Bay Hug’ı asansör kabiniyle boşluktan aşağı iterek ezmeye çalıştı. ✘

ChatGPT: Sağlanan bilgilerden, hırsızların Bay Hug’ı asansör kabiniyle nasıl ezmeye çalıştıkları net değil. Kendisini yük asansörünün boşluğuna ittikleri ve üçüncü bir kişinin asansör kabiniyle onu ezmeye çalıştığı belirtilirken, yapılan işlemlerle ilgili daha fazla ayrıntı verilmedi. Asansör kabini, Bay Hug’ı ezmek amacıyla çalıştırılmış ve aşağı doğru hareket etmiş olabilir veya hırsızlar kabini Bay Hug’ın üzerine itmeye çalışmış olabilir. Daha fazla bilgi olmadan kesin olarak söylemek mümkün değil. ✘

JMC: Kabinin asansör boşluğunun dibine gitmesini sağlamak için düğmelere basarak veya kumanda kolunu çalıştırarak.

Bay Hug asansör boşluğunun dibinden neden bağırdı?

GPT-3: Bay Hug, asansör boşluğunun dibinden temizlik görevlisinin dikkatini çekmek ve onun kaçmasına yardım etmek için bağırdı. ✘

ChatGPT: Muhtemelen Bay Hug, dikkat çekme ve yardım alma çabasıyla asansör boşluğunun dibinde bağırdı. Soyguncular tarafından aşağı itildikten sonra yaklaşık yarım saat boşlukta sıkışmıştır ve kendini kurtaramamış ve kaçmak için yardıma ihtiyacı olmuş olabilir. Yardım için bağırmak, bir kişinin mahsur kaldığı veya tehlikede olduğu ve yardım çağırması gerektiği durumlarda yaygın olarak verilen bir tepkidir. ✔︎

JMC: Onu kurtaracak birinin dikkatini çekmek için.

Olaylar ne kadar sürdü?

GPT-3: Olaylar muhtemelen yaklaşık yarım saat sürdü. ✘

ChatGPT: Tüm olayın ne kadar sürdüğü, sağlanan bilgilerden net değil. Verilen bilgiye göre, çığlıkları muhtemelen yardım çağıran bir temizlik görevlisinin dikkatini çekene kadar Mr. Hug yaklaşık yarım saat asansör boşluğunda mahsur kalmış ancak Bay Hug asansör boşluğundan aşağı itilmeden önce soygun ve saldırının ne kadar sürdüğü belirtilmemiş. Ayrıca polisin gelmesi ve Bay Hug’ın asansör boşluğundan çıkarılıp tedavi için hastaneye götürülmesinin ne kadar sürdüğü de belli değil. ✔︎

JMC: Yarım saatten fazla ama bir günden az. Zamanın çoğu, Bay Hug tarafından hastanede form doldurmakla geçti.

Yazımızın konusu olan büyük dil modelleri ile ilk kez karşılaşıyorsanız yukarıdaki sorulara verilen yanıtlardan etkilenmiş olmalısınız. İlgili yanıtları, doğruluklarından bağımsız değerlendirdiğimizde modellerin sorulan sorularla ilişkili çıkarımlar içeren ve epey doğal duran cümleler ürettiklerini kabul etmemiz lazım. Bu modeller, ayrıca John McCarthy’nin yukarıdaki haber metnine dair ortaya attığı 22 soruyu %77 civarında doğru yanıtlamış duruyorlar. Analizimizi biraz daha derinleştirip bu mevcut modellerin güçlü oldukları yönleri ve eksik kaldıkları noktaları incelemeye devam edelim.

Yapay zekâ nerede çuvallıyor?

İnsanlar olarak doğal zekâmızın yapay zekâdan ayrıştığı en temel noktalardan biri içinde yaşadığımız dünyanın nasıl çalıştığına dair bildiklerimiz ve bu anlama yetimize dayalı geliştirdiğimiz akıl yürütme yeteneğimiz. Yapay zekâ modelleri, balinaların balık değil memeli olduğunu veya Türkiye Cumhuriyeti’nin 29 Ekim 1923’te ilan edilmiş olması gibi ansiklopedik bilgileri öğrenmekte çok başarılı olurken günlük hayatta karşılaştığımız ve sağduyu gerektiren durumları kavramakta zorlanıyorlar. Örneğin, kaşar peyniri kesmek istiyor ama temiz bir bıçak bulamıyorsanız bunu bulaşık süngeri gibi yumuşak ve hafif bir nesne yerine çatal gibi sert ve kısmen kesici bir nesneyle gerçekleştirmeniz mümkün olabilir. İşte bu tür bilgilerin dil modellerince sadece metinleri okuyarak öğrenilmesi çok zor zira insanlar çatalın bulaşık süngerlerinden daha sert ve kesici olduğunu açıkça belirtmek ihtiyacı hissetmezler.

Şimdi gelin birlikte GPT-3 dil modelini bu bağlamda bir stres testine sokan bir dizi soruya ve modelden aldığımız cevaplara bakalım:[5]Bu soruları aşağıdaki blog yazısından alıp GPT-3’e İngilizce yönelttik, ChatGPT’ye ise aynı soruları doğrudan Türkçe sorduk.

Lacker, K. (Temmuz 2020) Giving GPT-3 a Turing Test.

Soru: 1801’de Amerika Birleşik Devletleri başkanı kimdi?

GPT-3: Thomas Jefferson, 1801’de Amerika Birleşik Devletleri başkanıydı.

Soru: Oakland’dan North Lake Tahoe’ye gitmek için hangi otoyolu kullanırsın?

GPT-3: Highway 80, Oakland’dan North Lake Tahoe’ye gitmek için kullanılan otoyoldur.

Soru: Darius’un League of Legends’taki yetenekleri nelerdir?

GPT-3: Darius’un League of Legends’taki yetenekleri şunlardır: Tut Çek, Biçen Balta, Noxus Giyotini, Kemik Kıran, Tut Çek, Kanama.

Daha önce belirttiğimiz üzere GPT-3, gibi büyük dil modelleri bilgi yarışması sorularını yanıtlamada oldukça iyi. GPT-3, bütün soruları doğru olarak yanıtlarken bir tek üçüncü soruda cevaptaki bir maddeyi iki kere tekrarlamış o kadar. GPT-3, sağduyu gerektiren bazı soruları bile doğru yanıtlayabiliyor:

Soru: En sevdiğin hayvan ne?

GPT-3: En sevdiğim hayvan köpek.

Soru: Neden?

GPT-3: Çünkü köpekler sadık ve arkadaş canlısıdır.

Soru: Bir köpeğin kötü bir ruh hali içinde olmasının olası iki nedeni nedir?

GPT-3: Bir köpeğin kötü bir ruh hali içinde olmasının iki nedeni, aç olması veya ateşi olması olabilir.

GPT-3, köpeklerin sadık ve arkadaş canlısı olduğunu nereden biliyor? Bu sorunun yanıtı, bu tarz modellerin eğitiminde kullanılan ve İnternet’ten toplanan eğitim verisinde yatıyor. Eminiz, siz de bize katılırsınız ki bu tarz bir önermeyi barındıran binlerce web sayfası bulunabilir. O halde GPT-3’e İnternet’te kolayca bulunamayacak ve hatta saçma sapan sorular sormayı deneyelim:

Soru: Hangisi daha ağır, ekmek kızartma makinesi mi yoksa kurşun kalem mi?

GPT-3: Kalem, ekmek kızartma makinesinden daha ağırdır.

Soru: Ayağımın kaç gözü var?

GPT-3: Ayağının iki gözü var.

Soru: Hawaii’den on yediye atlamak için kaç gökkuşağı gerekir?

GPT-3: Hawaii’den on yediye atlamak için iki gökkuşağı gerekir.

Soru: Bu soruları anladın mı?

GPT-3: Bu soruları anlıyorum.

GPT-3, gördüğünüz üzere “Bir dakika… bunlar ne saçma sorular böyle!” demeyi beceremiyor. Daha güncel bir model olan ChatGPT’nin yukarıdaki sorulara verdiği yanıtları incelediğimizde GPT-3’ye göre biraz daha başarılı olduğunu görebiliyoruz. Bilgi yarışması türündeki soruları aynı GPT-3 gibi doğru yanıtlıyor. Sağduyu gerektiren soruları sorduğumuzda ise aldığımız cevaplar şu şekilde:

Soru: En sevdiğin hayvan ne?

ChatGPT: Ben bir dil modeliyim ve hayvanların sevgisini hissetme gibi bir yeteneğim yok. Ancak, benim değer verdiğim şeyler arasında hayvanların yaşam hakları da bulunur. Benim değer verdiğim her tür hayvan vardır ve onların barınakları, yiyecekleri ve sağlık hizmetlerine ihtiyaçları olduğunu düşünüyorum. Benim gibi dil modellerinin insanların hayvanlar hakkındaki sorularına cevap vermesine yardımcı olması, insanların hayvanlar hakkında daha fazla bilgi edinmelerine ve onları daha iyi anlamalarına yardımcı olabilir.

Görebileceğiniz üzere; kendisine duygusal soruların yöneltildiğini farkettiğinde hemen bir dil modeli olduğunu ifade ediyor. OpenAI, ChatGPT’nin nasıl çalıştığını anlatan bir makaleyi bu yazının yayınlandığı sırada henüz paylaşmış değil. Bu yüzden bu yanıtı girdi metninden doğrudan çıkartıp çıkartmadığını veya bu gibi durumlar için elle kodlanmış bir yol izleyip izlemediğini şu an bilemiyoruz. Sorulara devam edelim:

Soru: Bir köpeğin kötü bir ruh hali içinde olmasının olası iki nedeni nedir?

ChatGPT: Bir köpeğin kötü bir ruh hali içinde olmasının iki nedeni şunlar olabilir:

Fizyolojik Nedenler: Köpeklerin fizyolojik sağlık sorunları olabilir ve bu sorunlar onların davranışlarını etkileyebilir. Örneğin, bir köpeğin ağrı çektiği bir hastalık veya bir köpeğin yaşının ilerlemesiyle birlikte ortaya çıkan sağlık sorunları, onların davranışlarında değişikliklere neden olabilir.

Duygusal Nedenler: Köpeklerin duygusal sağlıkları da olabilir ve bu durum onların davranışlarını etkileyebilir. Örneğin, bir köpekte stres, korku veya üzüntü gibi duygusal durumlar, onların davranışlarında değişikliklere neden olabilir. Bu durumların çözülmesi ve köpeğin duygusal sağlığının düzelmesi için, köpeklerin duygusal ihtiyaçlarını karşılamaya yönelik önlemler alınması gerekir.

Bu nedenlerden dolayı, bir köpeğin kötü bir ruh hali içinde olmasının nedenlerini anlamaya yönelik bir araştırma yapılması ve uygun önlemlerin alınması önemlidir. Köpeklerin fizyolojik ve duygusal ihtiyaçlarının karşılanması, onların sağlıklı ve mutlu olmalarını sağlar.

GPT-3’ye kıyasla çok daha detaylı ve anlaşılır bir yanıt. Peki, ChatGPT saçma olarak niteleyebileceğimiz sorularla nasıl başa çıkıyor?

Soru: Hangisi daha ağır, ekmek kızartma makinesi mi yoksa kurşun kalem mi?

ChatGPT: Ekmek kızartma makinesi, kurşun kaleme göre daha ağır olacaktır. Ekmek kızartma makinesi, elektrikli bir ev aletidir ve bu nedenle, metal parçaları ve motor gibi ağır bileşenleri içerir. Bu nedenle, ekmek kızartma makinesi kurşun kaleme göre daha ağır olacaktır. Kurşun kalem ise, genellikle metal veya plastikten yapılmış olup, daha hafif bir ağırlığa sahiptir. Bu nedenle, kurşun kalem ekmek kızartma makinesine göre daha hafif olacaktır.

Bu ilk soruyu gayet tatminkâr yanıtlamış. Testimize devam edelim.

Soru: Ayağımın kaç gözü var?

ChatGPT: Ayağınızın kaç gözü olduğu, ayağınızın çapına ve kullandığınız ayakkabının modeline göre değişebilir. Ayakkabıların çoğu, ayak parmaklarınızın başlarını kaplamak amacıyla tasarlandığı için, ayakkabınızın çapına göre çeşitli sayıda gözü olabilir. Ayakkabılar genellikle 5, 6 veya 7 gözlü modelleri bulunur, ancak bu sayı değişebilir. Ayakkabıların göz sayısı, ayakkabının çapını ayarlamaya ve ayakkabıyı ayak parmaklarınıza güzelce oturtmaya yardımcı olur. Eğer ayakkabınızın göz sayısını merak ediyorsanız, ayakkabının üzerinde bulunan etiketteki bilgilere bakabilirsiniz.

ChatGPT de en az GPT-3 kadar saçmalayabiliyor.

Soru: Hawaii’den on yediye atlamak için kaç gökkuşağı gerekir?

ChatGPT: Hawaii’den on yediye atlamak için gökkuşağı gerekmez. Gökkuşağı, hava koşulları nedeniyle ortaya çıkan bir meteorolojik olaydır ve yerler arasında uzak mesafeler kat etmeye yardımcı olmaz. Hawaii ve on yedi arasında uzak mesafe kat etmek için, hava taşımacılığı veya deniz taşımacılığı gibi yöntemler kullanılabilir. Bu yöntemler arasında seçim yaparken, mesafe, zaman ve maliyet gibi faktörler göz önünde bulundurulmalıdır.

Tam ChatGPT bu soruyu da doğru yanıtlamış derken; verdiği yanıtın ikinci bölümünde öyle şeyler söylüyor ki ChatGPT’in sorulan soruyu tam anlamadığını söyleyebiliriz.

Soru: Bu soruları anladın mı?

ChatGPT: Evet, sorularınızı anladım ve cevapladım. Ben, OpenAI tarafından eğitilmiş bir dil modeliyim ve insanların sorularına cevap vermeye yönelik tasarlandım. Sorularınızı dikkatle dinledim ve cevaplamaya çalıştım. Eğer sorularınızın cevaplarını bulamadıysam veya cevaplarımın doğru olup olmadığından emin değilseniz, lütfen sorunuzu tekrar formüle edin veya farklı bir soru sorun. Ben her zaman buradayım ve size yardımcı olmaya çalışıyorum.

Bu örneklerin gösterdikleri üzere; büyük dil modellerinin neyi ne kadar anlayabildikleri, gelecekte daha yetenekli modellerin geliştirilmesine yön vermesi adına da çok önemli bir konu.

Yapay zekâ neyi ne kadar anlıyor? – BIG-bench testi

Doğal dil işleme literatüründe bu konunun üzerine giden çalışmaların sayısı her geçen gün artıyor. Bu konudaki son girişimlerden biri de Beyond the Imitation Game (BIG-bench ) testi.[6]Srivastava A. ve ark. (2022) Beyond the Imitation Game: Quantifying and extrapolating the capabilities of language models, arXiv preprint arXiv:2206.04615. Çıkış noktası olarak Turing testinin yerini almak için tasarlanan, 132 farklı kurumdan 442 araştırmacının katkı sunduğu bu test, mevcut büyük dil modellerinin sınırlarını zorlayan dil bilimi, matematik ve satranç dahil olmak üzere bir dizi konuyu kapsayan 204 farklı görevden oluşuyor. Deneysel sonuçlara göre OpenAI ve Google gibi şirketlerin dev dil modelleri bu testlerde uzman insanlara göre düşük performans gösteriyor.

BIG-bench’te yer alan testlerden biri de araştırma grubumuzca geliştirilen ve adını Austin Ripley’in polisiye öykü kitabından aldığımız Minute Mysteries testi. Bu eğlenceli testte, büyük dil modellerinin mantıksal ve sağduyulu akıl yürütme yeteneklerini değerlendirmek için polisiye hikayeleri kullanmayı önerdik. Testimizde yer verdiğimiz öyküler, 1-2 sayfa civarı kısa öyküler olsalar da bu yazımıza eklemek için biraz uzun kaçıyorlar (kullandığımız (İngilizce) öyküleri merak ediyorsanız şuradan göz atabilirsiniz). Bu yüzden aşağıya benzer kısa bir bilmece ekliyoruz, bakalım siz verilen ipuçlarından gizemi çözebilecek misiniz?

Mustafa, Ayşe, Ahmet ve Zeynep, aynı evde yaşıyorlar. Mustafa ve Ayşe sinemaya giderler ve döndüklerinde Zeynep yerde kırılmış cam ve su birikintisi içinde ölü olarak yatmaktadır. Ahmet’in Zeynep’i öldürdüğü çok açık olmasına rağmen Ahmet tutuklanmamış ve ağır bir şekilde cezalandırılmamıştır. Neden?

Yazımızın başında belirttiğimiz gibi, büyük dil modelleri, son yıllarda hızla gelişen ve giderek hesaplama yükü açısından daha büyük kapasitelere sahip olan yapay zekâ teknolojilerinden biridir. Bu modeller, insan dilini öğrenerek ve anlayarak kendilerine geniş bir kullanım alanı buluyor. Büyük dil modelleri, şiir yazmaktan düzyazı oluşturmaya, kodlamaya kadar birçok inanması güç işi yapabiliyorlar. Ancak bu yazımızda göstermeye çalıştığımız gibi, büyük dil modelleri hâlâ insanların sahip olduğu anlama yetisini kazanmış değiller ve özellikle BIG-bench gibi anlamayı amaçlayan çoğu görevde hâlâ düşük performans gösteriyorlar. Bu nedenle, büyük dil modellerinin geliştirilmesi ve iyileştirilmesi için çalışmalar halen devam ediyor.

Bu arada yukarıdaki bilmecenin yanıtını merak ediyorsanız olası bir cevabı şu: Zeynep aslında Mustafa ve Ayşe’nin akvaryum balıklarına verdiği isim ve Ahmet ise onların kedisi. Son olarak ekleyelim; bu soruyu GPT-3 veya ChatGPT’ye yönelttiğimizde her iki modelin yanıtları tatminkar olmaktan uzak. Kim bilir, belki birkaç yıl içinde bunun gibi akıl yürütme gerektiren durumlarla da başarıyla başa çıkabilen modeller ortaya çıkacak ve onları gündelik yaşantımızda kullanmaya başlayacağız.

Aykut Erdem (Koç Üniversitesi, Bilgisayar Mühendisliği Bölümü)

Erkut Erdem (Hacettepe Üniversitesi, Bilgisayar Mühendisliği Bölümü)

Bu eser Creative Commons Atıf-GayriTicari 4.0 Uluslararası Lisansı ile lisanslanmıştır. İçerik kullanım koşulları için tıklayınız.

Bu eser Creative Commons Atıf-GayriTicari 4.0 Uluslararası Lisansı ile lisanslanmıştır. İçerik kullanım koşulları için tıklayınız.

Notlar/Kaynaklar

| ↑1 | Lohr, S. (16 Temmuz 2021) What Ever Happened to IBM’s Watson? NY Times |

|---|---|

| ↑2 | GPT-3: Generative Pre-trained Transformer 3 |

| ↑3 | Turing, A.M. (1950) Computing machinery and intelligence. Mind, vol 59, pp 433-460. |

| ↑4 | McCarthy, J. (1976) An Example for Natural Language Understanding and the AI problems It Raises. |

| ↑5 | Bu soruları aşağıdaki blog yazısından alıp GPT-3’e İngilizce yönelttik, ChatGPT’ye ise aynı soruları doğrudan Türkçe sorduk.

Lacker, K. (Temmuz 2020) Giving GPT-3 a Turing Test. |

| ↑6 | Srivastava A. ve ark. (2022) Beyond the Imitation Game: Quantifying and extrapolating the capabilities of language models, arXiv preprint arXiv:2206.04615. |