Bir insan kaç kişinin yüzünü tanıyabilir? Bir bilgisayar yazılımı hangi koşullar altında yüz tanımada başarılı? Bir insanın yüzünü uzaktan inceleyerek kalp atış hızını kestirebilir miyiz? Sahte yüzleri, yani birtakım bilgisayar programlarını sentezlenen yüzleri tespit edebilir miyiz? Bu yazıda bu ilginç sorulara değineceğiz ve bunları başaran bilgisayar yazılımlarının nasıl çalıştığına dair ipuçlarını ele alacağız.

Yüz analizi ile öğrenilen bilgiler ve kullanım alanları

İnsan yüzü ve yüz ifadelerinin analizi psikoloji, sinirbilim ve mühendisliği içeren disiplinler arası bir araştırma alanıdır. İnsanların neredeyse hiç çaba harcamadan yapabildiği yüz algılama* bilgisayarlar için hala çözülmeyi bekleyen bir sorun. Özellikle ışık farklılıkları, düşük çözünürlük vb. zorlayıcı koşullar altında bilgisayarlar, yüz algılamada insan performansını yakalayamıyor.

*Yüz algılama insanlar için sosyal etkileşimin çok önemli bir parçasıdır ve karmaşık süreçler içerir. Karşıdaki kişinin kim olduğu (hatta dost mu? düşman mı? sorgusu), cinsiyeti, yaşı, ne düşündüğü, ne hissettiği, ve nasıl davranacağı gibi bilgiler sosyal etkileşimlerimizi yönlendiren ve hatta hayatta kalmamızı sağlayan önemli bilgilerdir.[1]Little, A. C., Jones, B. C., & DeBruine, L. M. (2011). The many faces of research on face perception. In Philosophical Transactions of the Royal Society B: Biological Sciences (Vol. 366, Issue 1571, pp. 1634–1637). The Royal Society. https://doi.org/10.1098/rstb.2010.0386

Bilgisayarla görme ile otomatik yüz analizi sırasında amaç, mümkün olduğu kadar çok bilgi edinmektir.[2]Ranjan, R., Sankaranarayanan, S., Bansal, A., Bodla, N., Chen, J.-C., Patel, V. M., Castillo, C. D., & Chellappa, R. (2018). Deep Learning for Understanding Faces: Machines May Be Just as Good, or Better, than Humans. In IEEE Signal Processing Magazine (Vol. 35, Issue 1, pp. 66–83). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/msp.2017.2764116 Yüzün yeri ve pozisyonu, bakış açısı ve yönü, kişinin cinsiyeti, yaşı, hangi ırka ait olduğu ve kim olduğu duygusal durumu (örn. mutlu mu, üzgün mü?), zihinsel durumu (örn. dikkatli mi?), fiziksel durumu (örn. acı hissediyor mu?), dudak okuma ile ne söylemeye çalıştığı kestirilmeye çalışılan bilgiler arasında yer alır. Hatta, günümüzde insanlar tarafından algılanması güç olabilen yüz görüntüsünün ya da videosunun sahte olup olmadığı ve fizyolojik sinyallerin (örn. kalp atış hızı, kan basıncı) yüz videolarından kestirimi de mümkün.

Yüzün otomatik analiz edilmesi ile elde edilen bilgiler, pek çok teknolojik uygulamada hali hazırda kullanılıyor. Bankacılık sektöründe yüz doğrulama, cihazlara ve binalara güvenli erişim için yüz tanıma/doğrulama, ya da uzaktan eğitimde katılımcıların dikkat seviyesinin takip edilmesi ve eğitim akışının kişiye özel düzenlenmesi, eğlence ve sağlık alanındaki uygulamalar bunlardan sadece birkaçı.

Bu yazıda yüz analizi kapsamında üç ana konuya değineceğiz:

- yüz ifadesi tanıma,

- yüz tanıma/doğrulama ve

- yüz videolarından kalp atış hızı kestirimi

Fakat bu konulara değinmeden önce, her üç problem için de ön işleme adımları olan yüz saptama ve yüzdeki nirengi noktalarının saptanması üzerinde kısaca duracağız. Sonra yüz tanıma/doğrulama sistemlerine yönelik yanıltma girişimlerinden ve son olarak da yüz analizi teknolojilerinin günümüzdeki uygulama alanlarından bahsedeceğiz.

Yüz Saptama

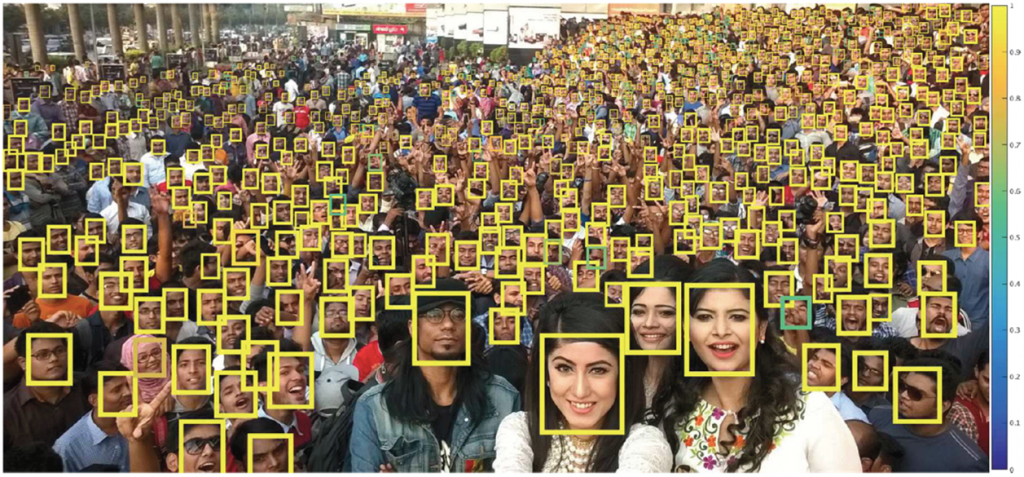

Yüz analizi yöntemlerinin ilk adımı yüz içeren sahnede insan yüzünün nerede olduğunun saptanması ve kutu içine alınarak belirlenmesidir. İnsan yüzleri görüntü içinde çok farklı çözünürlüğe, yüz pozuna, pozisyona, ışıklandırma seviyesine ve yüz ifadesine sahip olabileceği için, yüz tespiti çok çetin bir problemdir.

Çok küçük yüzleri de tespit etmek üzere derin öğrenme kullanan bir yönteme ait örneği Şekil 1’de görebilirsiniz.[3]Hu, P., & Ramanan, D. (2017). Finding Tiny Faces. In 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE. https://doi.org/10.1109/cvpr.2017.166 Tespit edilen yüzler renkli kutular ile çerçevelenmiş ve sarı renk algoritmanın en yüksek güven derecesi ile kestirim yaptığını gösteriyor.

Geçmişten günümüze yüz tespiti için pek çok yöntem önerildi. Bazı yöntemler resmin farklı büyüklükleri üzerinde pencere kaydırarak ve yüzü temsil eden örüntüleri (iki koyu göz bölgesi arasında açık tonda burun bölgesi gibi) arayarak, bazı yöntemler ise evrişimsel sinir ağlarının** farklı katmanlarından elde edilen bilgileri kullanarak tek seferde yüz tespiti yaparlar. Özellikle nesne tanımada da yüksek başarım sağlayan bölge tabanlı evrişimsel sinir ağları yüz tespiti için de kullanılmış ve yüksek başarımlar elde edilmiştir.[5]King, E. (2015) “Max-margin object detection,” arXiv:1502.00046.[6]Liu, D. Anguelov, D. Erhan, C. Szegedy, S. Reed, C.-Y. Fu, A. C. Berg, (2016) SSD: Single shot multibox detector, European Conference on Computer Vision, pp. 21–37.

**Evrişimsel sinir ağları, girdi olarak bir görüntüyü ya da vídeoyu alarak analiz eden, sınıflandırma ve nesne bulma gibi problemler için görüntüden uygun özellikleri elde etmeyi öğrenebilen derin yapay sinir ağlarıdır. Evrişimsel yapıda olması, görüntüdeki örüntüyü (örn. yüz) basitten karmaşığa doğru analiz etmesini sağlar ve ayrıca eğitim aşamasında öğrenilmesi gereken parametre sayısını azaltmak için de faydalıdır.

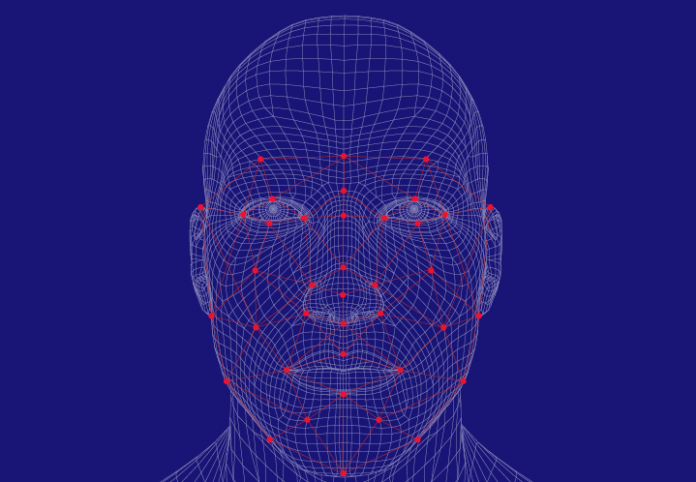

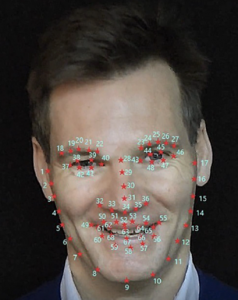

Yüzdeki önemli nirengi noktalarının saptanması

Yüzdeki belli başlı nirengi noktalarının saptanarak işaretlenmesi de yüz ve yüz ifadesi tanıma için önemli bir ön işleme adımıdır.[9]Çeliktutan, O., Ulukaya, S., & Sankur, B. (2013). A comparative study of face landmarking techniques. In EURASIP Journal on Image and Video Processing (Vol. 2013, Issue 1). Springer Science and Business Media LLC. https://doi.org/10.1186/1687-5281-2013-13 Bu noktalar, genellikle göz merkezleri ve göz kapağı kenarları, kaşlar, burun ucu, dudak köşeleri ve kenarları gibi belli başlı noktalardır. Şekil 2’de yüz üzerinde bulunan 68 nirengi noktası başarılı bir şekilde tespit edilmiş ve işaretlenmiş.[10]Kazemi, V., & Sullivan, J. (2014). One millisecond face alignment with an ensemble of regression trees. In 2014 IEEE Conference on Computer Vision and Pattern Recognition. 2014 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE. https://doi.org/10.1109/cvpr.2014.241 Yüzdeki noktalar tespit edildikten sonra yüz eğer yandan görünüyorsa, önden görünüme uygun olacak şekilde hizalamak için de kullanılabilir.

Yüz ifadesi tanıma

Yüz ifadeleri duygularımızı ve zihinsel durumumuzu ifade etmenin güçlü, doğal ve evrensel bir yoludur.[11]Li, S., & Deng, W. (2020). Deep Facial Expression Recognition: A Survey. In IEEE Transactions on Affective Computing (pp. 1–1). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/taffc.2020.2981446 Araştırmalar, insanların yüz ifadeleriyle ve kültürlerden bağımsız olarak evrensel şekilde gösterebildiği altı temel duygu olduğunu gösteriyor.[12]Ekman, P. (1994). Strong evidence for universals in facial expressions: A reply to Russell’s mistaken critique. In Psychological Bulletin (Vol. 115, Issue 2, pp. 268–287). American Psychological Association (APA). https://doi.org/10.1037/0033-2909.115.2.268 Bu duygular kızgınlık, iğrenme, mutluluk, üzüntü ve şaşırma olarak sınıflandırılıyor.

Daha fazla sayıda duygu ve zihinsel durumu (dikkatli, düşünceli vb.) ifade etmek için yüzümüzdeki kaslarla yaptığımız çok küçük hareketleri tanıyan yöntemler[13]Ekman, P. “Facial action coding system (FACS)”, A Human Face, 2002. ve altı temel duygu gibi sınıflara yerleştirmeden pozitif-negatif, az-çok gibi ölçeklerde sürekli olarak ifade etmeye çalışan modeller de mevcut.[14]Gunes, H., & Schuller, B. (2013). Categorical and dimensional affect analysis in continuous input: Current trends and future directions. In Image and Vision Computing (Vol. 31, Issue 2, pp. 120–136). Elsevier BV. https://doi.org/10.1016/j.imavis.2012.06.016

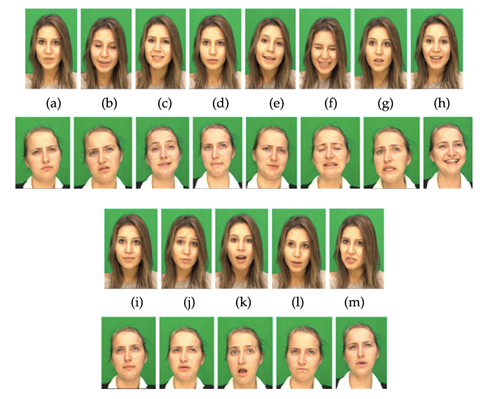

Yüz ifadesi tanıma için makine öğrenmesi yöntemlerinin eğitilmesi amacıyla farklı ifadelerde yüzler içeren erişime açık veri tabanları mevcut. Bunlardan bazıları deneklerden rol yapmaları istenerek kayıt ediliyor,[15]Lucey, P., Cohn, J. F., Kanade, T., Saragih, J., Ambadar, Z., & Matthews, I. (2010). The Extended Cohn-Kanade Dataset (CK+): A complete dataset for action unit and emotion-specified expression. In 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition – Workshops. 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops (CVPR Workshops). IEEE. https://doi.org/10.1109/cvprw.2010.5543262 bazıları da yarı-doğal yüz ifadelerini yakalamaya çalışıyor.[16]Li, S., & Deng, W. (2020). Deep Facial Expression Recognition: A Survey. In IEEE Transactions on Affective Computing (pp. 1–1). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/taffc.2020.2981446[17]Zhalehpour, S., Onder, O., Akhtar, Z., & Erdem, C. E. (2017). BAUM-1: A Spontaneous Audio-Visual Face Database of Affective and Mental States. In IEEE Transactions on Affective Computing (Vol. 8, Issue 3, pp. 300–313). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/taffc.2016.2553038 Şekil 3’te bazı duygusal ve zihinsel durumlara ait videolardan oluşan bir veri kümesinden örnek kareler gösteriliyor. Yüz ifadelerini tek bir fotoğraf yerine üç boyutta temsil eden ve derinlik bilgisini de algılayabilen cihazlar ile kayıt edilmiş veri kümeleri de mevcut.[18]Savran, A., Alyüz, N., Dibeklioğlu, H., Çeliktutan, O., Gökberk, B., Sankur, B., & Akarun, L. (2008). Bosphorus Database for 3D Face Analysis. In Lecture Notes in Computer Science (pp. 47–56). Springer Berlin Heidelberg. https://doi.org/10.1007/978-3-540-89991-4_6

Literatürde son yıllarda geliştirilen yüz ifadesi tanıma yöntemleri durağan resimlerden ya da dinamik videolardan yararlanarak evrişimsel sinir ağı kullanan programlarla, yani yapay zekâ eğitirler. Hatta, birden çok ağı birlikte kullanan yöntemlerin daha başarılı sonuçlar verdiği gözleniyor. Derin öğrenme kullanan yöntemlerin yüksek başarımda tanıma gerçekleştirebilmesi için çok sayıda ve farklı koşullarda kayıt edilmiş veriye ihtiyacı var.[19]Li, S., & Deng, W. (2020). Deep Facial Expression Recognition: A Survey. In IEEE Transactions on Affective Computing (pp. 1–1). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/taffc.2020.2981446

Yüz tanıma / Doğrulama

Bilgisayarla yüz tanımanın tarihi 1950’lere ve 1960’lara kadar uzanıyor, ancak bu konudaki araştırmaların 1970’lerde başladığı söylenebilir. Donanımdaki gelişmeler ve güvenlikle ilgili uygulamalardaki artan önemle birlikte alandaki gelişmeler 1990’ların başından itibaren hız kazandı.[21]Taskiran, M., Kahraman, N., & Erdem, C. E. (2020). Face recognition: Past, present and future (a review). In Digital Signal Processing (Vol. 106, p. 102809). Elsevier BV. https://doi.org/10.1016/j.dsp.2020.102809[22]Belhumeur, P. N., Hespanha, J. P., & Kriegman, D. J. (1997). Eigenfaces vs. Fisherfaces: recognition using class specific linear projection. In IEEE Transactions on Pattern Analysis and Machine Intelligence (Vol. 19, Issue 7, pp. 711–720). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/34.598228

Literatürdeki yüz tanıma algoritmaları, görüntü tabanlı ve video tabanlı yöntemler olarak iki ana gruba ayrılıyor.[23]Taskiran, M., Kahraman, N., & Erdem, C. E. (2020). Face recognition: Past, present and future (a review). In Digital Signal Processing (Vol. 106, p. 102809). Elsevier BV. https://doi.org/10.1016/j.dsp.2020.102809 Görüntü tabanlı algoritmalar, fiziksel görünümü kullanarak bir kişiyi tanımaya çalışırken, video tabanlı algoritmalar ise fiziksel görünümün yanı sıra zamanla görünümde oluşan değişiklikleri veya yüzdeki hareket bilgilerini de yüz tanıma amacıyla kullanır.

Bilgisayarlar için yüz tanıma algoritmaları geliştirilmesi sürecinde insanların yüzleri nasıl tanıdığı üzerine birçok çalışma yapıldı. Modern toplumlarda insanların ortalama 5000 kişinin yüzünü tanıyabildiğini biliyoruz.[24]Jenkins, R., Dowsett, A. J., & Burton, A. M. (2018). How many faces do people know? In Proceedings of the Royal Society B: Biological Sciences (Vol. 285, Issue 1888, p. 20181319). The Royal Society. https://doi.org/10.1098/rspb.2018.1319 İnsan görme sisteminin, yüzleri tanımak için, yüzlerin statik ve dinamik özelliklerinin işlenmesi amacıyla karmaşık sinir yolları barındırdığı gösterilmiştir.[25]Vaina, L. M., Solomon, J., Chowdhury, S., Sinha, P., & Belliveau, J. W. (2001). Functional neuroanatomy of biological motion perception in humans. In Proceedings of the National Academy of Sciences (Vol. 98, Issue 20, pp. 11656–11661). Proceedings of the National Academy of Sciences. https://doi.org/10.1073/pnas.191374198

Son yıllarda bilgisayarla yüz tanıma araştırmalarında, insan görsel sistemindeki karmaşık sinir ağının modellenmesi çalışıldı. 2014’ten itibaren laboratuvarda değil de, herhangi bir kısıtlama uygulamadan doğal ortamlarda, yaşamın içinden çekilen yüz binlerce yüz resmi üzerinde gerçekleştirilen testler sonucunda, derin öğrenme ağlarına dayalı yüz tanıma sistemlerinin insan yüz tanıma başarımını yakaladığı ve hatta son zamanlarda da bu başarımın daha yukarıya taşındığı görüldü. Örneğin, DeepFace yöntemi,[26]Taigman, Y., Yang, M., Ranzato, M., & Wolf, L. (2014). DeepFace: Closing the Gap to Human-Level Performance in Face Verification. In 2014 IEEE Conference on Computer Vision and Pattern Recognition. 2014 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE. https://doi.org/10.1109/cvpr.2014.220 binlerce kişiye ait resimler içeren veri kümeleri ile gerçekleştirilen testlerde %97,35’lik yüz tanıma başarımı elde etti ve bu elde edilen değer insan performansına neredeyse eşit (%97,53). Daha sonraki çalışmalarda bilgisayar ile yüz tanıma başarımları %99,80’lere ulaştı.

Derin öğrenme kullanan algoritmaların yüz tanımadaki bu başarısını daha iyi anlamak için, eğitilen evrişimsel sinir ağlarının her katmanında farklı özelliklerin tespit edildiğini söylemeliyiz. İlk katmanlar ayrıtlar gibi basit yapıları; orta katmanlar göz, burun gibi yüz bileşenlerini ve son katmanlar da yüzü bütünsel temsil eden öznitelikleri çıkarmayı öğreniyor.[27]Wang, M., & Deng, W. (2021). Deep face recognition: A survey. In Neurocomputing (Vol. 429, pp. 215–244). Elsevier BV. https://doi.org/10.1016/j.neucom.2020.10.081

Öte yandan derin öğrenme temelli yüz tanıma yöntemlerinin bile performanslarının olumsuz koşullar altında (örneğin aydınlatma, kontrast değişimleri ve bulanıklık) önemli ölçüde azaldığı görülüyor.[28]Grm, K., Štruc, V., Artiges, A., Caron, M., & Ekenel, H. K. (2017). Strengths and weaknesses of deep learning models for face recognition against image degradations. In IET Biometrics (Vol. 7, Issue 1, pp. 81–89). Institution of Engineering and Technology (IET). https://doi.org/10.1049/iet-bmt.2017.0083[29]Mohapatra, J., Weng, T., Chen, P., Liu, S., & Daniel, L. (2019). Towards Verifying Robustness of Neural Networks Against Semantic Perturbations. ArXiv, abs/1912.09533. Bu tür durumlar karşısında daha dayanıklı sistemler oluşturmak amacıyla, farklı derin öğrenme mimarileri geliştirilmesi ya da yüz ifadelerinden elde edilen kişisel bilgilerin de yardımcı biyometrik veri olarak kullanıldığı hibrit yüz tanıma sistemlerinin oluşturulması söz konusu.[30]Taskiran, M., Kahraman, N., & Eroglu Erdem, C. (2020). Hybrid face recognition under adverse conditions using appearance‐based and dynamic features of smile expression. In IET Biometrics (Vol. 10, Issue 1, pp. 99–115). Institution of Engineering and Technology (IET). https://doi.org/10.1049/bme2.12006

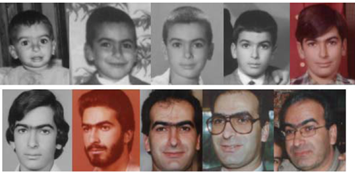

Şekil 4’te de görülebileceği gibi yaş değişimleri de yüz tanıma sistemlerini zorlayan önemli bir etken.

Yüz tanıma/doğrulama sistemlerini yanıltma girişimleri

Yüz tanıma sistemlerini yanıltmak amacıyla kullanılabilen sahte resim ya da videoları veya gerçekçi üç boyutlu yüz maskelerini tespit etmek amacıyla da yöntemler geliştiriliyor.[33]Li, H., He, P., Wang, S., Rocha, A., Jiang, X., & Kot, A. C. (2018). Learning Generalized Deep Feature Representation for Face Anti-Spoofing. In IEEE Transactions on Information Forensics and Security (Vol. 13, Issue 10, pp. 2639–2652). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/tifs.2018.2825949 ((F. Gündoğar, Ç. E. Erdem, “Presentation Attack Detection for Face Recognition using Remote Photoplethysmography and Cascaded Fusion”, Turkish Journal of Electrical Engineering and Computer Sciences, 2021, DOI: 10.3906/elk-2010-93.)) Örneğin, Şekil 5’da üst sıradaki resimlerde gerçek (canlı) insanlara ait görüntüler, alt sıradaki resimler ise yanıltma girişimlerinde kullanılan görüntüler, yani cansız fotoğraflar, videolar ya da üç boyutlu yüz maskeleri. Amaç, başka bir kişinin fotoğrafını ya da videosunu yüz tanıma sistemine göstererek, sistemin yanlış onay vermesini sağlamak olduğundan gerçek ile yanıltıcı görüntülerin ayırt edilmesi, yüz tanıma sistemlerinin güvenliği açısından son derece önemli.

Yüz videolarından kalp atış hızı kestirimi

Yüz videolarının otomatik analizi ile kalp atış hızı ve solunum hızı gibi fizyolojik bilgilerin de kestirimi mümkün[38]Poh, M.-Z., McDuff, D. J., & Picard, R. W. (2010). Non-contact, automated cardiac pulse measurements using video imaging and blind source separation. In Optics Express (Vol. 18, Issue 10, p. 10762). The Optical Society. https://doi.org/10.1364/oe.18.010762[39]Demirezen, H., & Eroglu Erdem, C. (2021). Heart rate estimation from facial videos using nonlinear mode decomposition and improved consistency check. In Signal, Image and Video Processing (Vol. 15, Issue 7, pp. 1415–1423). Springer Science and Business Media LLC. https://doi.org/10.1007/s11760-021-01873-x ve son yıllarda derin öğrenme tabanlı yöntemlerin de kullanılması sayesinde oldukça başarılı sonuçlar elde ediliyor.[40]Liu, X., Fromm, J., Patel, S., McDuff, D. (2020) Multi-task temporal shift attention networks for on-device contactless vitals measurement, NeurIPS Oral presentation.

Kalbimizin her atışında, deri altında yer alan kılcal damarlardaki kan hacmi artar. Kanımızda bulunan hemoglobin sayesinde deri üzerine düşen ışığın emilmesi arttığından cildimizden yansıyan ışığın miktarı her kalp atışı ile gözle fark edilemeyecek seviyede değişir. Yüz videolarındaki bu renk değişikliği verileri, bilgisayarla görme ve sinyal işleme yöntemleri ile analiz edilerek kalp atış hızı kestirimi mümkün olur.

Cilt ile temas etmeden kalp atışını kestirmenin özellikle yeni doğanlar gibi hassas ciltlere sahip hastaların takibi gibi pek çok uygulama alanı mevcut. Yüz videolarından kalp atış hızı kestiriminin diğer bir uygulama alanı ise derin öğrenme yöntemleri (çekişmeli üretici ağlar) ile üretilmiş ve son derece gerçekçi görünen fakat sahte olan yüz videoların tespit edilmesidir.[41]Ciftci, U. A., Demir, I., & Yin, L. (2020). FakeCatcher: Detection of Synthetic Portrait Videos using Biological Signals. In IEEE Transactions on Pattern Analysis and Machine Intelligence (pp. 1–1). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/tpami.2020.3009287[42]Erdem, A., Erdem, E. (2020) Yapay Zeka ile Gerçekliğin Üretimi”, Sarkaç, https://sarkac.org/2020/09/yapay-zeka-ile-gercekligin-uretimi/

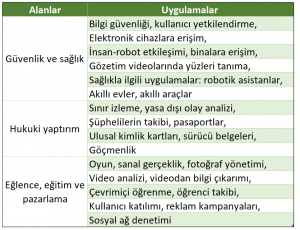

Yüz analizi teknolojilerinin kullanım alanları

Yukarıda yüz ifadesi tanıma, yüz tanıma ve doğrulama, yüz videolarından fizyolojik sinyallerin kestirilmesi gibi güncel araştırma konularına değindik.

Yüz binlerce yüz resmi kullanılarak gerçekleştirilen testler sonucunda bilgisayarlı yüz tanımada elde edilen yüksek başarımlar, yüz biyometrisi, güvenlik ve kolluk kuvvetleri, sağlık, eğitim, pazarlama, finans, eğlence ve insan-bilgisayar etkileşimi gibi birçok uygulama alanına sahip temel biyometrik özelliklerden biri olmasını sağlamıştır. Tablo 1’de yüz tanıma sistemlerinin ana uygulama alanları ve bu alanlarla ilgili özel uygulamalar listelenmiştir.

Yüz ifadesi analizinin sağlık ve eğitim sektörlerinde de önemli kullanım alanları var. Örneğin başka şekilde iletişim kuramayan bireylerde yüz ifadelerinden acı çekip çekmediği kestirilerek ağrı yönetimi daha etkin yapılabiliyor.[43]Hassan, T., Seus, D., Wollenberg, J., Weitz, K., Kunz, M., Lautenbacher, S., Garbas, J.-U., & Schmid, U. (2021). Automatic Detection of Pain from Facial Expressions: A Survey. In IEEE Transactions on Pattern Analysis and Machine Intelligence (Vol. 43, Issue 6, pp. 1815–1831). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/tpami.2019.2958341 Diğer bir örnek de çocuklara uygulanan psikoterapi sırasında yüz ifadelerinin otomatik takip edilmesi[44]Halfon, S., Doyran, M., Türkmen, B., Oktay, E. A., & Salah, A. A. (2020). Multimodal affect analysis of psychodynamic play therapy. In Psychotherapy Research (Vol. 31, Issue 3, pp. 313–328). Informa UK Limited. https://doi.org/10.1080/10503307.2020.1839141 ya da özellikle otistik çocukların yüz ifadelerinin analiz edilerek tedaviye ne kadar cevap verdiğinin ölçülmesidir.[45]Rudovic, O., Utsumi, Y., Lee, J., Hernandez, J., Castello Ferrer, E., Schuller, B., Picard, R. “CultureNet: A Deep Learning Approach for Engagement Intensity Estimation from Face Images of Children with Autism.” IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS 2018). https://www.media.mit.edu/publications/culturenet-a-deep-learning-approach-for-engagement-intensity-estimation-from-face-images-of-children-with-autism/

Yeni gelişmekte olan yüz analizi teknolojileri sayesinde heyecan verici ve hayatımızı kolaylaştırıcı başka uygulama alanları da mutlaka ortaya çıkacaktır.

Çiğdem Eroğlu Erdem (Marmara Üniversitesi, Mühendislik Fakültesi, Bilgisayar Mühendisliği Bölümü)

Murat Taşkıran (Yıldız Teknik Üniversitesi, Elektronik ve Haberleşme Mühendisliği Bölümü)

Bu eser Creative Commons Atıf-GayriTicari 4.0 Uluslararası Lisansı ile lisanslanmıştır. İçerik kullanım koşulları için tıklayınız.

Bu eser Creative Commons Atıf-GayriTicari 4.0 Uluslararası Lisansı ile lisanslanmıştır. İçerik kullanım koşulları için tıklayınız.

Notlar/Kaynaklar

| ↑1 | Little, A. C., Jones, B. C., & DeBruine, L. M. (2011). The many faces of research on face perception. In Philosophical Transactions of the Royal Society B: Biological Sciences (Vol. 366, Issue 1571, pp. 1634–1637). The Royal Society. https://doi.org/10.1098/rstb.2010.0386 |

|---|---|

| ↑2 | Ranjan, R., Sankaranarayanan, S., Bansal, A., Bodla, N., Chen, J.-C., Patel, V. M., Castillo, C. D., & Chellappa, R. (2018). Deep Learning for Understanding Faces: Machines May Be Just as Good, or Better, than Humans. In IEEE Signal Processing Magazine (Vol. 35, Issue 1, pp. 66–83). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/msp.2017.2764116 |

| ↑3, ↑4 | Hu, P., & Ramanan, D. (2017). Finding Tiny Faces. In 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE. https://doi.org/10.1109/cvpr.2017.166 |

| ↑5 | King, E. (2015) “Max-margin object detection,” arXiv:1502.00046. |

| ↑6 | Liu, D. Anguelov, D. Erhan, C. Szegedy, S. Reed, C.-Y. Fu, A. C. Berg, (2016) SSD: Single shot multibox detector, European Conference on Computer Vision, pp. 21–37. |

| ↑7, ↑10 | Kazemi, V., & Sullivan, J. (2014). One millisecond face alignment with an ensemble of regression trees. In 2014 IEEE Conference on Computer Vision and Pattern Recognition. 2014 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE. https://doi.org/10.1109/cvpr.2014.241 |

| ↑8 | Dibeklioğlu, H., Salah, A. A., & Gevers, T. (2012). Are You Really Smiling at Me? Spontaneous versus Posed Enjoyment Smiles. In Computer Vision – ECCV 2012 (pp. 525–538). Springer Berlin Heidelberg. https://doi.org/10.1007/978-3-642-33712-3_38 |

| ↑9 | Çeliktutan, O., Ulukaya, S., & Sankur, B. (2013). A comparative study of face landmarking techniques. In EURASIP Journal on Image and Video Processing (Vol. 2013, Issue 1). Springer Science and Business Media LLC. https://doi.org/10.1186/1687-5281-2013-13 |

| ↑11, ↑16, ↑19 | Li, S., & Deng, W. (2020). Deep Facial Expression Recognition: A Survey. In IEEE Transactions on Affective Computing (pp. 1–1). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/taffc.2020.2981446 |

| ↑12 | Ekman, P. (1994). Strong evidence for universals in facial expressions: A reply to Russell’s mistaken critique. In Psychological Bulletin (Vol. 115, Issue 2, pp. 268–287). American Psychological Association (APA). https://doi.org/10.1037/0033-2909.115.2.268 |

| ↑13 | Ekman, P. “Facial action coding system (FACS)”, A Human Face, 2002. |

| ↑14 | Gunes, H., & Schuller, B. (2013). Categorical and dimensional affect analysis in continuous input: Current trends and future directions. In Image and Vision Computing (Vol. 31, Issue 2, pp. 120–136). Elsevier BV. https://doi.org/10.1016/j.imavis.2012.06.016 |

| ↑15 | Lucey, P., Cohn, J. F., Kanade, T., Saragih, J., Ambadar, Z., & Matthews, I. (2010). The Extended Cohn-Kanade Dataset (CK+): A complete dataset for action unit and emotion-specified expression. In 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition – Workshops. 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops (CVPR Workshops). IEEE. https://doi.org/10.1109/cvprw.2010.5543262 |

| ↑17 | Zhalehpour, S., Onder, O., Akhtar, Z., & Erdem, C. E. (2017). BAUM-1: A Spontaneous Audio-Visual Face Database of Affective and Mental States. In IEEE Transactions on Affective Computing (Vol. 8, Issue 3, pp. 300–313). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/taffc.2016.2553038 |

| ↑18 | Savran, A., Alyüz, N., Dibeklioğlu, H., Çeliktutan, O., Gökberk, B., Sankur, B., & Akarun, L. (2008). Bosphorus Database for 3D Face Analysis. In Lecture Notes in Computer Science (pp. 47–56). Springer Berlin Heidelberg. https://doi.org/10.1007/978-3-540-89991-4_6 |

| ↑20 | Zhalehpour, S., Onder, O., Akhtar, Z., & Erdem, C. E. (2017). BAUM-1: A Spontaneous Audio-Visual Face Database of Affective and Mental States. In IEEE Transactions on Affective Computing (Vol. 8, Issue 3, pp. 300–313). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/taffc.2016.2553038. |

| ↑21, ↑23 | Taskiran, M., Kahraman, N., & Erdem, C. E. (2020). Face recognition: Past, present and future (a review). In Digital Signal Processing (Vol. 106, p. 102809). Elsevier BV. https://doi.org/10.1016/j.dsp.2020.102809 |

| ↑22 | Belhumeur, P. N., Hespanha, J. P., & Kriegman, D. J. (1997). Eigenfaces vs. Fisherfaces: recognition using class specific linear projection. In IEEE Transactions on Pattern Analysis and Machine Intelligence (Vol. 19, Issue 7, pp. 711–720). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/34.598228 |

| ↑24 | Jenkins, R., Dowsett, A. J., & Burton, A. M. (2018). How many faces do people know? In Proceedings of the Royal Society B: Biological Sciences (Vol. 285, Issue 1888, p. 20181319). The Royal Society. https://doi.org/10.1098/rspb.2018.1319 |

| ↑25 | Vaina, L. M., Solomon, J., Chowdhury, S., Sinha, P., & Belliveau, J. W. (2001). Functional neuroanatomy of biological motion perception in humans. In Proceedings of the National Academy of Sciences (Vol. 98, Issue 20, pp. 11656–11661). Proceedings of the National Academy of Sciences. https://doi.org/10.1073/pnas.191374198 |

| ↑26 | Taigman, Y., Yang, M., Ranzato, M., & Wolf, L. (2014). DeepFace: Closing the Gap to Human-Level Performance in Face Verification. In 2014 IEEE Conference on Computer Vision and Pattern Recognition. 2014 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE. https://doi.org/10.1109/cvpr.2014.220 |

| ↑27 | Wang, M., & Deng, W. (2021). Deep face recognition: A survey. In Neurocomputing (Vol. 429, pp. 215–244). Elsevier BV. https://doi.org/10.1016/j.neucom.2020.10.081 |

| ↑28 | Grm, K., Štruc, V., Artiges, A., Caron, M., & Ekenel, H. K. (2017). Strengths and weaknesses of deep learning models for face recognition against image degradations. In IET Biometrics (Vol. 7, Issue 1, pp. 81–89). Institution of Engineering and Technology (IET). https://doi.org/10.1049/iet-bmt.2017.0083 |

| ↑29 | Mohapatra, J., Weng, T., Chen, P., Liu, S., & Daniel, L. (2019). Towards Verifying Robustness of Neural Networks Against Semantic Perturbations. ArXiv, abs/1912.09533. |

| ↑30 | Taskiran, M., Kahraman, N., & Eroglu Erdem, C. (2020). Hybrid face recognition under adverse conditions using appearance‐based and dynamic features of smile expression. In IET Biometrics (Vol. 10, Issue 1, pp. 99–115). Institution of Engineering and Technology (IET). https://doi.org/10.1049/bme2.12006 |

| ↑31 | Tripathi, R. K., & Jalal, A. S. (2021). A Local Descriptor for Age Invariant Face Recognition under Uncontrolled Environment. In 2021 2nd International Conference on Secure Cyber Computing and Communications (ICSCCC). 2021 2nd International Conference on Secure Cyber Computing and Communications (ICSCCC). IEEE. https://doi.org/10.1109/icsccc51823.2021.9478154 |

| ↑32 | Lanitis, A. (2008). Comparative Evaluation of Automatic Age Progression Methodologies. In EURASIP Journal on Advances in Signal Processing (Vol. 2008, Issue 1, p. 239480). Springer Science and Business Media LLC. https://doi.org/10.1155/2008/239480 |

| ↑33 | Li, H., He, P., Wang, S., Rocha, A., Jiang, X., & Kot, A. C. (2018). Learning Generalized Deep Feature Representation for Face Anti-Spoofing. In IEEE Transactions on Information Forensics and Security (Vol. 13, Issue 10, pp. 2639–2652). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/tifs.2018.2825949 |

| ↑34 | Chingovska,I., A. Anjos A., Marcel, S. (2012) “On the effectiveness of local binary patterns in face anti-spoofing,” 2012 BIOSIG – Proceedings of the International Conference of Biometrics Special Interest Group (BIOSIG), pp. 1-7. |

| ↑35 | Costa-Pazo, A., Bhattacharjee, S., Vazquez-Fernandez, E., & Marcel, S. (2016). The Replay-Mobile Face Presentation-Attack Database. In 2016 International Conference of the Biometrics Special Interest Group (BIOSIG). 2016 15th International Conference of the Biometrics Special Interest Group (BIOSIG). IEEE. https://doi.org/10.1109/biosig.2016.7736936 |

| ↑36 | Erdogmus, N., & Marcel, S. (2013). Spoofing in 2D face recognition with 3D masks and anti-spoofing with Kinect. In 2013 IEEE Sixth International Conference on Biometrics: Theory, Applications and Systems (BTAS). 2013 IEEE 6th International Conference on Biometrics: Theory, Applications and Systems (BTAS). IEEE. https://doi.org/10.1109/btas.2013.6712688 |

| ↑37 | Di Wen, Hu Han, & Jain, A. K. (2015). Face Spoof Detection With Image Distortion Analysis. In IEEE Transactions on Information Forensics and Security (Vol. 10, Issue 4, pp. 746–761). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/tifs.2015.2400395 |

| ↑38 | Poh, M.-Z., McDuff, D. J., & Picard, R. W. (2010). Non-contact, automated cardiac pulse measurements using video imaging and blind source separation. In Optics Express (Vol. 18, Issue 10, p. 10762). The Optical Society. https://doi.org/10.1364/oe.18.010762 |

| ↑39 | Demirezen, H., & Eroglu Erdem, C. (2021). Heart rate estimation from facial videos using nonlinear mode decomposition and improved consistency check. In Signal, Image and Video Processing (Vol. 15, Issue 7, pp. 1415–1423). Springer Science and Business Media LLC. https://doi.org/10.1007/s11760-021-01873-x |

| ↑40 | Liu, X., Fromm, J., Patel, S., McDuff, D. (2020) Multi-task temporal shift attention networks for on-device contactless vitals measurement, NeurIPS Oral presentation. |

| ↑41 | Ciftci, U. A., Demir, I., & Yin, L. (2020). FakeCatcher: Detection of Synthetic Portrait Videos using Biological Signals. In IEEE Transactions on Pattern Analysis and Machine Intelligence (pp. 1–1). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/tpami.2020.3009287 |

| ↑42 | Erdem, A., Erdem, E. (2020) Yapay Zeka ile Gerçekliğin Üretimi”, Sarkaç, https://sarkac.org/2020/09/yapay-zeka-ile-gercekligin-uretimi/ |

| ↑43 | Hassan, T., Seus, D., Wollenberg, J., Weitz, K., Kunz, M., Lautenbacher, S., Garbas, J.-U., & Schmid, U. (2021). Automatic Detection of Pain from Facial Expressions: A Survey. In IEEE Transactions on Pattern Analysis and Machine Intelligence (Vol. 43, Issue 6, pp. 1815–1831). Institute of Electrical and Electronics Engineers (IEEE). https://doi.org/10.1109/tpami.2019.2958341 |

| ↑44 | Halfon, S., Doyran, M., Türkmen, B., Oktay, E. A., & Salah, A. A. (2020). Multimodal affect analysis of psychodynamic play therapy. In Psychotherapy Research (Vol. 31, Issue 3, pp. 313–328). Informa UK Limited. https://doi.org/10.1080/10503307.2020.1839141 |

| ↑45 | Rudovic, O., Utsumi, Y., Lee, J., Hernandez, J., Castello Ferrer, E., Schuller, B., Picard, R. “CultureNet: A Deep Learning Approach for Engagement Intensity Estimation from Face Images of Children with Autism.” IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS 2018). https://www.media.mit.edu/publications/culturenet-a-deep-learning-approach-for-engagement-intensity-estimation-from-face-images-of-children-with-autism/ |