Mustafa Akgül’ün anısına….

Arka Plandaki İtici Güçler

Son bir yıl içerisinde hızlı bir değer artışı sürecine giren Bitcoin ve kripto paralar doğal olarak giderek artan bir ilgi ve merak konusu olmaya başladı. Bitcoin itibari paraların[1] yerini mi alacak? Ulus devletler ve onların merkez bankaları para üzerindeki kontrolü mü kaybediyorlar? Bitcoin değer patlaması 1600’lerdeki “lale soğanı balonu” veya 1700’lerdeki “güney denizi balonu” veya 2000’lerin başındaki “dotcom balonu” gibi patlaması kaçınılmaz, tarihe geçecek bir finansal balon mu? Bitcoin dolardan kaçışın adresi mi oldu? Bu ve benzeri sorular kamuoyunun gündemini giderek daha çok meşgul etmeye başladı.

Bu yazı, Bitcoin ve kripto para sistemlerinin teknik özelliklerinden önce bu yeni fenomeni doğuran ve kaçınılmaz kılan tarihsel etmenleri ayırt ederek konuya daha geniş bir perspektiften yaklaşmayı amaçlıyor. Öte yandan, Bitcoin ve kripto paralar, bunları olanaklı kılan Blockchain teknolojisinin potansiyel uygulamalarından sadece bir tanesi. Ekonomik ve sosyal boyutta geleceğe yönelik esas dönüşüm, Blockchain teknolojisinin olanak sağladığı “akıllı kontrat” ların para dışındaki yenilikçi uygulamalarıyla yaşanacak gibi görünüyor.

Yazıda geleceğe dönük bu boyutu da irdeleyeceğiz Ama önce tarihsel etmenlerden birincisiyle yani “bilişim devrimi” nin somut ifadesiyle başlayalım.

Moore Kanunu

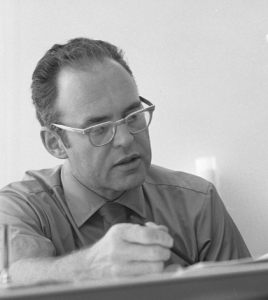

Intel firmasının kurucularından Gordon Moore, 1965 yılında mikroişlemci üreten Fairchild Semiconductors firmasında Arge direktörü olarak çalışırken bir gözlem yapar. Bu gözlemini de Electronics dergisinde yayınlanan ve yarı-iletken teknolojisinin geleceğine ilişkin bir makalede paylaşır. Bu gözleme göre, birim alana sığdırılabilen aktif eleman (transistör) sayısı her iki yılda bir ikiye katlanmaktadır. Bilgi işlem kapasitesindeki artış hızına ters orantılı olarak bilgi işlem ve hafıza maliyetleri de aynı oranda düşmektedir. Transistör, sonuçta açık veya kapalı konumuyla bir bit’lik temel “bilgi”[2] birimini ifade ettiği için Moore’un gözlemi en yalın haliyle bilgi işlem kapasitesindeki artış hızını ifade etmektedir. Moore’un gözlemi yıllar içerisinde neredeyse şaşmaz bir tutarlılıkla geçerliliğini korur. O kadar ki, bu olgu Moore Kanunu olarak adlandırılacaktır.

Moore Kanunu ile ifadesini bulan gelişimi rakamlara dökecek olursak “bilişim devrimi” olarak adlandırılan son 50 yıllık dönemde bilgi işlem kapasitesinin 25 kez 2 katına çıktığı veya 225 kat, yani kabaca 30 milyon kat arttığı, bilgi işlem maliyetlerinin de 30 milyon kat düştüğü sonucuna varırız. Bu gelişme ancak sanayi devrimindeki üretkenlik patlamasıyla kıyaslanabilecek niteliktedir. Ancak bu kez makinelerle çoğaltılan sanayi ürünleri değil, Alan Turing’in öngördüğü gibi bilginin, bilgiyle işlenerek yine bilginin üretildiği yeni türden bir üretim biçimidir sözkonusu olan.

Bu başdöndürücü süreci ekonomik terimlerle ifade edecek olursak bilgiyi çoğaltma ve işlemenin marjinal maliyetinin sıfıra yakınsadığını söyleyebiliriz. Marjinal maliyetlerin sıfıra yakınsadığı bir süreçte fiyatlar da kaçınılmaz olarak sıfıra yuvarlanacaktır. Nitekim de öyle olur, bilgiyi işleyen yazılımlardan başlayarak dijitalleşerek bilgiye dönüştürülen herşeyin giderek kamusal mala (public good) dönüşmeye başladığı bir sürece girilir.

Moore Kanunu neden önemli? Bitcoin gibi tasarımında onlarca yıl sonrasını hesaba katmak zorunda olan bir algoritmanın bilgi işlem kapasitesindeki artışı mutlaka hesaba katması gerekiyordu. Nitekim, Bitcoin’un arz tarafını belirleyen algoritma, Bitcoin tedavülündeki “azalan verim” özelliğini belirlerken Moore Kanunu da hesaba katarak geliştirilmiştir.

Özgür ve Açık Kaynaklı Yazılım

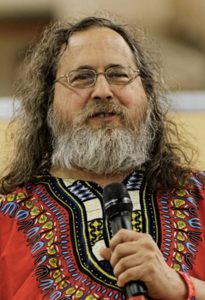

Etmenlerin ikincisine değinmek üzere bilişim devriminin ilk yıllarına dönüyoruz. 1970’lerin ortalarında MIT (Massachusetts Teknoloji Enstitüsü) Bilgisayar Bilimi ve Yapay Zeka Araştırma Laboratuarında yazılım araştırma uzmanı olarak çalışmakta olan Harvard Üniversitesi Fizik Bölümü mezunu Richard Stallman, mesleği icabı kelimenin gerçek anlamıyla bir hacker’di. Görevi gereği yazılım ve donanımları “hack”, ederek yani kesip biçip yapıp bozarak araştırma ve geliştirme çalışmalarını yürütüyordu. “Hacker” terimi de özgün haliyle amatör radyoculuktan beri süregelen bu amatör ruhu ifade eder. Stallman da o dönemin hacker topluluklarında özellikle hızla gelişen yazılım teknolojileri ile ilgili yoğun bir bilgi ve deneyim paylaşım sürecini yaşıyordu. Ancak bu paylaşım ve geliştirmenin önünde patent ve lisans kısıtları ciddi engel oluşturmaktaydı. Oysa, Stallman’a göre bilgiyi çoğaltmanın herhangi bir maliyeti olmadığı gibi bilgiyi paylaştığınızda bilgiden mahrum da kalınmıyordu. Bilgi üretiminde maddi ürünlerden çok farklı bir durum sözkonusuydu. Bilginin üzerinde mülkiyet tesis etmek hem anlamlı değil, hem de uzun vadede mümkün değildi.

Stallman, meseleye temelinden yaklaşarak kodları herkese açık bir işletim sistemi yazmaya girişti. GNU adını verdiği bu işletim sistemi yazılımlar ailesini herkesin paylaşımına ve geliştirme çabasına açtı. Ancak bir sorun vardı. Kötü niyetli bir kullanıcının bunu gidip kendi üzerine patentlemesini önlemek ve paylaşımı sürdürebilmek için bu yazılımlara hukuki bir tanım gerekiyordu. Stallman, GPL (General Public Licence – genel halka açık lisans) adıyla bir lisans geliştirdi ve paylaşıma açık yazılımlar için uygulamaya koydu. Buna göre, GPL lisanslı bir yazılımı kopyalayarak kullanmak, üzerinde değişiklik yapmak, çoğaltmak ve dağıtmak serbestti. Yasak olan tek şey ücret karşılığı satmaya çalışılsa dahi yazılım kodlarını kapalı tutmaktı. GNU epey yol aldı ancak projenin tamamlanması için bu işletim sisteminin temelinde yer alması gereken çekirdek yazılım (kernel) tamamlanamıyordu.

Bu eksiği 1991’de Linus Torvalds adında bir yükseklisans öğrencisi tamamladı. Tezinde kadim UNIX işletim sisteminin kişisel bilgisayarlar için bir türevini geliştirdi ve buna kendi adından devşirerek Linux adını verdi. Torvalds da Linux’u GPL lisansıyla paylaşıma açtı. İki çaba birleşince GNU/Linux özgür ve açık kaynaklı ilk işletim sistemi olarak hızla yayılmaya başladı.

Birkaç yıl içerisinde, özellikle de internetin hızla yaygınlaşmasıyla GPL lisanslı yazılımlar artmaya ve yaygınlaşmaya başladı. Bugüne gelindiğinde, açık kaynak üretim modeli artık ana akım haline geldi diyebiliriz. Özgür yazılım ile açık kaynaklı yazılım arasında erbabının ayrım yaptığı hukuki ve felsefi incelikler bu yazının kapsamı dışında. Bizi bu aşamada ilgilendiren, açık kaynaklı yazılımın bir normatif tercih konusu olmaktan çok bir zorunluluk olarak ortaya çıkmış ve yayılmış olmasıdır.

Yazılımların ücretsiz olması büyük hızda yaygınlaşmasını sağlıyor; Bu ürünler etrafında farklı ölçülerde katkıda bulunan çok kalabalık bir kullanıcı/geliştirici topluluğu oluşuyor; Deneyim ve bilgi paylaşımı bu ürünlerin hızla hatalarından arınarak dayanıklı ürünler haline gelmelerini sağlıyor; Paylaşılan bu bilgi ve deneyim birikimi, eşsiz bir kullanıcı destek kaynağı oluşturuyor. Yazılım öylesine karmaşık, sürekli geliştirme isteyen ve kullanıcı kitleleri kısa sürede milyarları bulabilen bir üretim alanı ki, şirketler bünyelerinde ne kadar personel istihdam ederlerse etsinler, açık kaynak modelinin yarattığı devasa kolektif üretim ve destek gücüyle artık rekabet edemiyor ve birçok yazılım teknolojisi alanından çekiliyorlar. Yazılım teknolojisinin en ileri uygulamaları, kâr amacı gütmeyen vakıflar, kolektif topluluklar veya Github gibi milyonlarca birey veya gurubun yazılımlarını paylaştığı platformlarda geliştiriliyor ve GPL benzeri lisanslarla dağıtılıyor.

Küresel ölçekte internet altyapısını çalıştıran sunucu bilgisayarların içinde Linux/Unix kullanım oranı istatistikleri %70 ile %98 arasında değişebiliyor[3], aktif web sunucularının %87’si[4], veri tabanlarının %47’si açık kaynaklı yazılımlar [5]. Hızla artmakta olan açık kaynaklı veri tabanı yazılımları payının birkaç yıla kalmadan patentli yazılımları geçeceği tahmin ediliyor. Dünyadaki süper bilgisayarların %99’u Linux işletim sistemiyle çalışıyor. Aktif çalışmakta olan linux sisteminin sayısı 1,7 milyarı geçiyor.

Mobil cihaz pazarının %88’ine hakim olan Android işletim sistemi linux tabanlı ve açık kaynaklı[6], kalan %12’yi oluşturan iOS (iPhone işletim sistemi) ise görece kapalı olmakla birlikte bir unix türevi olan açık kaynaklı FreeBSD işletim sisteminden devşirme. Açık kaynaklı yazılımlar ücretli satılıyor olsaydı ortada dönecek parasal hacmin tahminleri 300 ile 400 milyar dolar arasında dolanıyor. Araştırmalara göre, yazılım mühendislerinin %70’i doğrudan %22’si dolaylı olmak üzere açık kaynak projelerine katkıda bulunuyor[7].

Peki açık kaynak yazılımları geliştirenlerin getirisi ücret veya hisse değilse nedir ki bu denli yaygın bir çalışma biçimine dönüşebiliyor?

Onlar açısından bakacak olursak, kullandıkları ücretsiz yazılım araçlarıyla ücretsiz geliştirdikleri veya katkıda bulundukları bu ürünler sayesinde hızla yayılan ve kullanım alanı bulan bir yazılım/teknolojide nitelikli uzmanlık kazanma ve adam-saat hizmetlerini yüksek ücret karşılığında pazarlama olanağı elde ediyorlar. Bir başka deyişle, açık kaynak ekonomisinde üretim araçları ücretsiz, ürünler de ücretsiz ancak nitelikli emek ücretli.

Bilişim devrimi, üzerinde fiyat etiketi olmadan dünyanın ekonomisini belirlemeye başlayan bilgi ürünlerini ardı ardına geliştirirken, ekonomi bilimini de fiyatın olmadığı bir pazar mekanizmasında bunların nasıl dağıldığını açıklamak için yeni teorik araçlar bulmak zorunda bırakıyor.

Kolektif İşlem Gücü Ağları

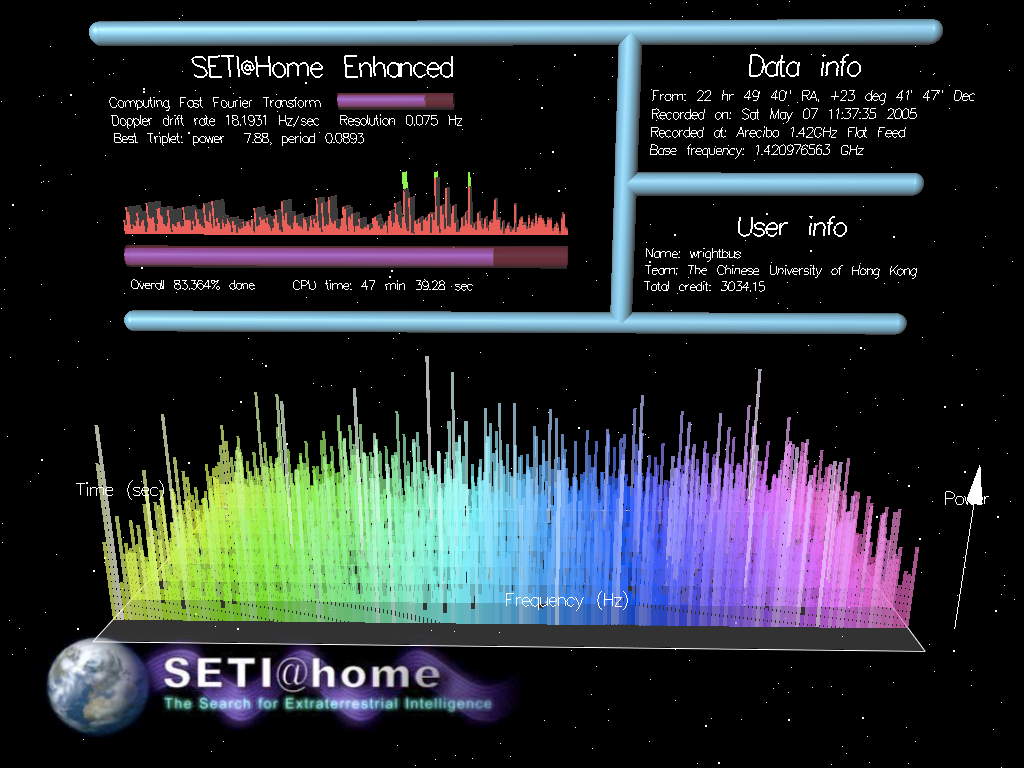

Üçüncü etmeni en güzel anlatacak örnek, uzayda akıllı uygarlık arayışını yıllardır sürdürmekte olan SETI enstitüsünün SETI@home projesidir[8]. SETI, akıllı bir uygarlıktan genel sinyali ayırt edebilmek amacıyla Hat Creek Radyo Teleskop Gözlemevi’ndeki 40’dan fazla antenle uzayın her köşesinden devasa miktarda sinyal kaydediyor. Bu verilerin karmaşık algoritmalarla işlenerek dış etkilerden temizlenmesi gerekliliği SETI’nin önünde çok ciddi bir engel yaratıyordu. Bu işi makul sürede yapabilecek işlem gücü mevcut değildi. Dönemin en gelişmiş süperbilgisayarının kullanılması halinde dahi tüm verinin işlenmesinin yüz yılı aşacağı hesaplanıyordu.

Sene 1999’du ve internet henüz emekleme aşamasındaydı. Ortaya atılan basit bir fikir inanılmaz bir işlem gücü yaratılmasına neden oldu. SETI@home adında bir ekran koruyucu (screensaver) programı gönüllülere dağıtılacaktı ve makinalarının atıl zamanlarında SETI’den veri paketleri indirip işleyerek geri gönderecekti. Eğer akıllı uygarlığa rastlanırsa, o veri paketini işleyen makinenin sahibi gönüllüye de bir ithafta bulunulacaktı. Bu fikrin tutacağına kimse pek inanmamış olacak ki en fazla 1000 kişinin bunu kullanacağını düşünerek bu amaçla basit bir toplama bilgisayar devreye alındı. Servis açıldıktan kısa bir süre sonra bilgisayar çöktü. Kullanıcı sayısı bir milyonu geçmişti! Sistemler derhal yükseltildi ve SETI@home zaman içerisinde 5 milyon kullanıcısıyla 10 yıl sonrasının en gelişmiş süperbilgisayardan bile daha yüksek bir işlem gücünü gönüllülerle yaratmayı başardı. “Dağıtılmış Bilgi İşlem”’in ilk ve en parlak örneklerinden birisidir bu.

Dağıtılmış bilgi işlem, Grid bilgi işlem gibi adlarla anılan kişiden kişiye (peer-to-peer) kolektif işlem gücü ağlarının uygulama alanları da hızla yayıldı. Bilimsel araştırmalar dışında Napster, eDonkey, BitTorrent gibi dosya paylaşım ağları, mobil cihazlardan trafik hız bilgilerini toplayıp kullanıcılara harita üzerinden rota çizen ticari navigasyon uygulamalarına kadar farklı türde dağıtılmış kolektif bir işlem gücü ağları doğdu ve çeşitlenerek artıyor.

Bunlar arasında en yüksek güce ulaşmış olanı kuşkusuz son yıllarda kazandığı yaygınlığıyla bugüne dek görülmüş en yüksek işlem gücüne ulaşmış olan Bitcoin madenci ağıdır. Bu olağanüstü kapasite 2017’de saniyede 6 milyon tera hash işlem kapasitesine ulaştı. Hash işlemi kriptografide kullanılan ve değişken uzunluktaki bir veri kümesini sabit uzunlukta bir şifreye dönüştüren işlemdir. Bir tera hash bir trilyon hash olduğuna göre, Bitcoin madenci ağı bir saniyede 6 milyon $\times$ 1 trilyon, yani 6 x 1018 hash işlem gerçekleştirebiliyor demektir.

Bilişim devrimi, yazılım gibi işlem gücünün de kolektif olarak geliştirilmesini ve kullanımını zorunlu hale getiriyor.

Artık açık kaynaklı bir yazılımla kolektif dağıtılmış bir işlem gücü ağı üzerinde tasarlanmış, kişiden kişiye (peer-to-peer) bir nakit sistemi olan Bitcoin’e gelebiliriz.

Yazının ikinci bölümü için tıklayınız.

Not: “Bilişim Devrimi Işığında Kripto Paralar” başlıklı yazının ikinci bölümünde Bitcoin’un ve kripto paraların ortaya çıkışı ve işleyişi ile paranın geleneksel tanımı ve işlevleri ışığında kripto paraların değerlendirilmesi; üçüncü bölümünde ise blockchain teknolojisinin ticari, ekonomik ve sosyal boyutta getirebileceği potansiyel değişiklikler ele alınacak.

Mehmet İnhan

_____________________________________

Açıklama ve Kaynaklar:

[1] İtibari para veya “fiat money”, altın veya gümüş gibi kıymetli madenler karşılığı basılmayan, bir başka deyişle karşılığı olmadan basılan ve ilgili hükümetin “yasal ödeme aracı” (legal tender) olarak belirlediği paraya verilen addır. 1960’larda ABD’de özellikle Vietnam savaşı harcamalarıyla aşırı artmış olan dolar hacmi, altın karşılığı kısıtını uygulanması olanaksız boyuta getirince Nixon yönetimi, 1971 yılında doların altın karşılığı değişim yükümlülüğünü tek taraflı olarak iptal etmiş böylelikle uluslararası para sisteminde yeni bir döneme girilmiştir. 2.Dünya Savaşı sonrası Bretton Woods anlaşmasıyla tanımlanmış olan para birimleri arasındaki sabit kur rejimi de bu adım sonucunda fiilen son bulmuş ve aynı yıl Smithsonian anlaşması ile belirlendiği şekliyle kurların belirli sınırlar içerisinde dalgalanmasına olanak verilmiş, bir süre sonra ise kurlar tamamen dalgalanmaya bırakılmıştır.

[2] Bilgi günlük türkçemizde hem malumat, enformasyon (information) hem de bili, irfan (knowledge) karşılığı olarak kullanılmaktadır. Bu yazıda Bilgi, birinci anlamda, yani Bilgi Teorisinde kullanıldığı biçimiyle, içeriğinden bağımsız olarak nicel olarak ölçülebilen bir büyüklüğü ifade etmektedir.

[3] https://en.wikipedia.org/wiki/Usage_share_of_operating_systems

[4] Netcraft web sunucu pazar araştırması, Şubat 2017: https://news.netcraft.com/archives/2017/02/27/february-2017-web-server-survey.html

[5] DB-Engines Ranking – (Veri Tabanı motorları sıralaması) https://db-engines.com/en/ranking_osvsc

[6] https://www.statista.com/statistics/266136/global-market-share-held-by-smartphone-operating-systems/

[7] https://www.techrepublic.com/article/why-every-developer-is-an-open-source-developer-these-days/